AI

300 Inhalte

Entdecken Sie unser Archiv zu tiefgehenden Inhalte zum Thema AI.

Zweiwöchige Sprints mit verzögertem Feedback bremsen Java-Teams aus. Lange Wartezeiten zwischen Refinement und Review verhindern schnelle Iterationen. KI-gestützte Entwicklung ermöglicht tägliche Mini-Sprints: Teams planen morgens, implementieren tagsüber und reviewen abends. Die Folge: ein Paradigmenwechsel von Sprint-Batches zu kontinuierlichem Flow.

Agentic AI gilt als Zauber- und Wundermittel für mehr Effizienz, Produktivität und Qualität in Unternehmen. Dabei wird allerdings gerne vergessen, dass die Resultate ihrer Arbeit nicht immer valide sind. Das kann zu inkorrekten und damit potenziell gefährlichen Ergebnissen führen. KI-Agenten sind immer nur so gut, sicher und Compliance-konform wie das Regelwerk, in das sie eingebunden sind.

Es gibt in jeder technischen Generation diesen einen Moment, in dem man das Gefühl hat, der Boden unter den Füßen verändert sich. Meist passiert es nicht plötzlich. Es geschieht schleichend, fast unmerklich, und doch weiß man: Hier verschiebt sich etwas Grundsätzliches. In den letzten Jahren war dieser Moment eindeutig. Künstliche Intelligenz hat die Softwareentwicklung nicht nur beschleunigt, son..

Java

AI

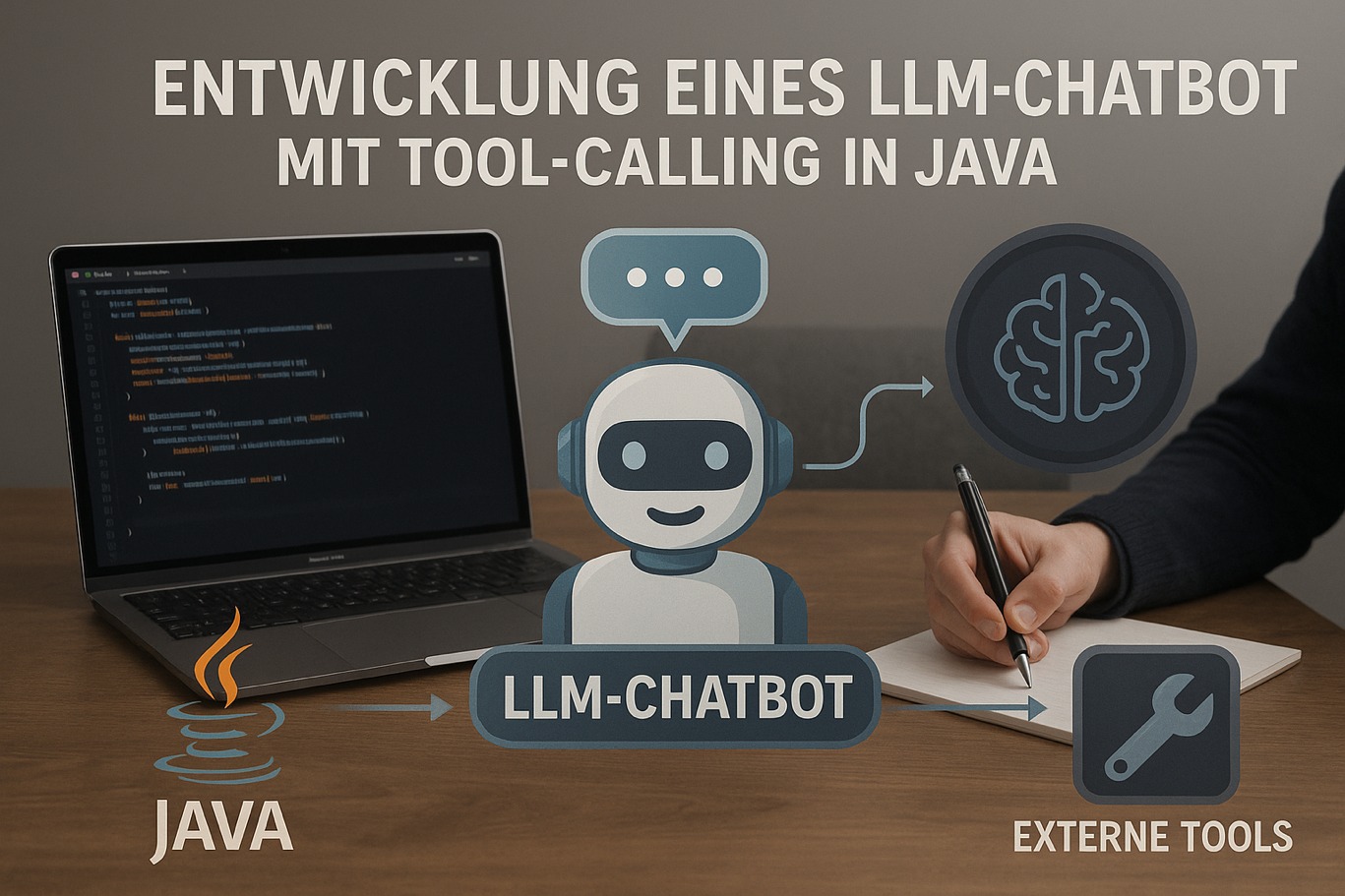

Entwicklung eines LLM-Chatbots mit Tool-Calling in Java – Teil 1: Erstellung eines einfachen Chatbots

Willkommen zu einem umfassenden Tutorial über die Entwicklung eines LLM-Chatbots (Large Language Model) mit Tool-Calling-Funktionalität in Java. Dieser Leitfaden führt Sie von der Erstellung eines einfachen Chatbots bis hin zur Implementierung ausgefeilter Tool-Calling-Features, die es Ihrem LLM ermöglichen, mit externen Systemen und APIs zu interagieren.

Die Gründe – oder die Hindernisse –, analytische Workloads in die Cloud zu verschieben, haben sich prinzipiell in den letzten fünf bis zehn Jahren kaum verändert: flexible Reaktion auf Lastschwankungen, Kosten sparen, schnellere und einfache Provisionierung, Einsparung eigener Ressourcen. Durch die Entwicklung der Technologie und Strategie der Hersteller einerseits und die politische Situation and..