Die Cloud-Ausgaben stiegen 2023 weltweit um 14 Prozent, der Anteil an Infrastructure as a Service (IaaS) sogar um 25 Prozent (siehe Abbildung 1). Die Prognosen für 2024 und 2025 liegen erneut oberhalb dieses Wachstums. Ursache hierfür sind Anwendungssysteme, die hohe Anforderungen an Verfügbarkeit und Leistungsfähigkeit der IT-Infrastruktur haben. Prominente Beispiele sind Kryptowährungen, KI-Anwendungen und klassische Applikationen großer Unternehmen mit hohem Berechnungsaufwand oder sehr hohem Nutzungsgrad.

Emissionen

Mit steigenden IT-Ausgaben erhöhen sich auch die Emissionen. Der IKT-Sektor ist für etwa 4 Prozent der globalen Treibhausgasemissionen verantwortlich [1], im Vergleich dazu trug der weltweite Luftverkehr 2022 nur 2 Prozent bei. Seit der Etablierung von Kryptowährungen und der KI-Revolution ist klar, dass der Ressourcenverbrauch weiter massiv steigen wird [2].

Kostensenkung in IT

IT ist für viele Unternehmen ein bedeutender Produktivitätsmotor, aber auch ein erheblicher Kostenfaktor. Der Wunsch nach IT-Kostensenkungen ist nicht neu. Zwei Faktoren bestimmen die Kosten, „Verbrauch“ und „Preis“:

- IT-Kosten = Verbrauch × Preis

Während Preise für IT-Infrastruktur-Dienstleistungen seit vielen Jahren mit Benchmarks verglichen werden, fällt Unternehmen die Optimierung des Verbrauchs schwer. Warum?

Hinderungsgründe

Der hochgradig individuelle Verbrauch unternehmensspezifischer Applikationen macht den Vergleich über Unternehmensgrenzen hinweg schwierig. Es ist oft intransparent, ob ein Optimierungspotenzial vorliegt. Ohne einen Nachweis wird kein Management aktiv. Zudem nimmt niemand gerne Änderungen am laufenden System vor. Die Hoffnung, dass alles hinreichend optimal läuft, ist größer als der Mut, dies zu hinterfragen.

Unternehmen reduzieren Verbrauch nicht, weil die Transparenz über das schlummernde Effizienzpotenzial fehlt.

Aber: Wenn dieses Potenzial gehoben wird, sinken Emissionen und (!) Kosten.

Das klingt nach einer spannenden Win-Win-Situation in der heutigen Zeit. Eine vielversprechende Motivation ist eine zweigeteilte Analyse dieses Potenzials.

Schritt 1: Assessment

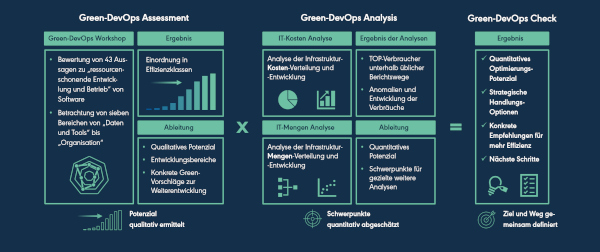

Durch ein Assessment kann ermittelt werden, wie stark der Fokus bereits auf Ressourcenschonung in der Softwareentwicklung und im Betrieb liegt (siehe Abbildung 2, links).

Abb. 2: Green-DevOps-Check – grafische Übersicht: Vorgehensmodell

Hierzu diskutieren interne Mitarbeitende gemeinsam in einem moderierten Workshop 43 Aussagen aus den sieben Bereichen:

- Daten und Tools,

- Team und Kommunikation,

- Umsetzung,

- Planung und Management,

- Leadership,

- Organisation,

- Kultur.

Einige dieser Aussagen lauten (verkürzt):

- IT-Verbrauch liegt aktuell vor, steht allen Beteiligten zur Verfügung und Veränderungen werden regelmäßig kommuniziert.

- Historische Daten zum IT-Verbrauch werden genutzt, um Anomalien zu entdecken.

- Es wird kontinuierlich in die Weiterentwicklung des Monitorings und in Schulung von Mitarbeitenden investiert.

- IT und Fachbereich bewerten fachliche Anforderungen und technische Lösungen gemeinsam.

- Standards zur Vermeidung von unnötigem IT-Verbrauch existieren.

- Business hat ein Interesse an geringem Verbrauch.

- Verantwortliche für Emissionen und Kosten besitzen das Budget, diese zu reduzieren.

- Optimierungsvorschläge werden wertgeschätzt und bedürfen keiner Rechtfertigung.

Alle 43 Aussagen tragen dazu bei, dass Ressourcen geschont werden können. Solche Rahmenbedingungen unterstützen ein systematisches Ressourcenmanagement in der IT, das Emissionen und Kosten reduziert. Wir definieren dies als Green-DevOps (siehe Abbildung 3).

Abb. 3: Definition Green-DevOps

Die Mitarbeitenden bewerten gemeinsam auf einer 5er-Skala, wie gut jede dieser 43 Aussagen die aktuellen Rahmenbedingungen im eigenen Unternehmen beschreibt. Im Ergebnis erhält das Unternehmen eine nachvollziehbare Einschätzung zur aktuellen Ressourcenschonung in Softwareentwicklung und -betrieb. Auf dieser Grundlage erhalten Entscheiderinnen und Entscheider ein klares Bild davon, wie hoch die Wahrscheinlichkeit der Existenz eines noch ungenutzten Einsparpotenzials ist.

Das Assessment ist unter einer Creative-Common-Lizenz veröffentlicht und kann kostenfrei im eigenen Unternehmen genutzt werden. Über den QR-Code aus Abbildung 4 kann es bezogen werden.

Abb. 4: Link auf MS-Forms-Seite zum Green- DevOps-Assessment von oktobit

In der Praxis liegen die Ergebnisse des Assessments unterschiedlicher Unternehmen überwiegend im mittleren Bereich der „reaktiven Vermeidung von unnötigen IT-Ressourcen“. In der Ausprägung der Bewertungsbereiche gibt es teils starke Unterschiede. Stärken liegen manchmal eher in der Datenlage und dafür ausbaubarer Nutzung dieser, oder umgekehrt zeigt sich eine schwach ausgeprägte Datenlage, aber dafür sehr flexible Umsetzung von erkanntem Optimierungspotenzial.

Schritt 2: Datenanalyse

Auf der anderen Seite ermöglicht die IT-Kosten-/Mengenanalyse (siehe Abbildung 2, Mitte) eine gründliche Untersuchung von Zahlen, Daten und Fakten aus dem IT-Controlling. Dabei werden unter anderem folgende Fragen beleuchtet:

- Wie hoch sind die Gesamt-IT-Betriebskosten und wie haben sie sich entwickelt?

- Was sind die größten Kostenblöcke, wie haben sie sich entwickelt und was sind die Mengentreiber hierfür?

- Wie verteilt sich der Ressourceneinsatz (Menge) auf die verursachenden Applikationen?

- Wie hoch ist der Anteil der Applikationen, der für 80 Prozent der Kosten/ Mengen verantwortlich ist?

- Welche Entwicklung von Applikationsverbräuchen wird durch das bestehende Kostenreporting verdeckt?

Dabei sind insbesondere zwei Vorgehensweisen relevant.

a) Mengenentwicklung unabhängig von Preisen

Zu empfehlen ist insbesondere eine Betrachtung von Mengen und weniger von Kosten. Dabei lassen sich Mengen unterschiedlicher Dienstleistungen schlecht vergleichen. Wer weiß schon, ob es hilfreicher ist, 10 TByte Speicher einzusparen oder einen Server mit einer CPU und vier Kernen? Daher hat es sich als hilfreich erwiesen, Kosten über mehrere Jahre mit einheitlichen aktuellen Preisen zu simulieren. Auf diese Weise kann die Entwicklung unabhängig von Preisschwankungen transparent dargestellt werden und gleichzeitig bleiben unterschiedliche Dienstleistungen mit ihrem Beitrag zu den Kosten vergleichbar.

b) Fokussierung auf Verursacher

Außerdem wird in der Analyse auf die unmittelbaren Verbraucher von Ressourcen (IT-Systeme) geschaut, statt auf eine verursachungsgerechte Kostenverteilung. Hierdurch soll vermieden werden, dass Kostensteigerungen an einer Stelle aufgrund einer breiten Kostenverteilung so weit „verrieseln“, dass sie an der zugeordneten Stelle nicht mehr ins Gewicht fallen. Hierzu ein Beispiel: Kosten für ein unternehmensweites System zu Verwaltung von Personendaten werden im Controlling auf die Abnehmer, beispielsweise Sparten einer Versicherung, aufgeteilt: Kfz, Leben, Gesundheit, Sachen, Unfall, Haftpflicht, Rechtschutz, … bekommen alle ihren Anteil der Kosten des Systems zugeordnet. Steigen die Kosten dafür um zum Beispiel 10 Prozent und € 100.000, erhalten die Sparten nur ihren Anteil dieser Kostensteigerung. Im eigenen großen Kostenblock fällt diese Steigerung nicht mehr ins Gewicht.

Es geht also darum, Anomalien im Verbrauch an der Quelle zu identifizieren, weder primär in den Kosten noch aus Kostenträgersicht. Aus diesen mengenbasierten applikationsbezogenen Analysen lassen sich bereits quantifizierbare konkrete Ansatzpunkte identifizieren. Außerdem liegen mit der Datenanalyse Menge, Verteilung und Entwicklung des Ressourceneinsatzes offen. Das ist eine wichtige Voraussetzung für das Ergebnis.

Ergebnis – Green-DevOps-Check

Mit dem Green-DevOps-Check lässt sich die Höhe des Effizienzpotenzials realistisch abschätzen.

Gemeinsam mit dem Ergebnis des Assessments (Wahrscheinlichkeit der Existenz von Optimierungspotenzial) lässt sich nach der Datenanalyse die Höhe des Effizienzpotenzials realistisch abschätzen und konkrete erste Empfehlungen aussprechen (siehe Abbildung 2, rechts).

Erfahrungswerte aus anderen Unternehmen mit ihrem Assessment-Ergebnis und dort erzielten Verbrauchsreduzierungen stützen eine Abschätzung. Dabei ist nicht relevant, welche Systeme bei den Unternehmen im Einsatz sind. Verglichen werden das qualitative Effizienzpotenzial aus dem Assessment sowie die analysierten Kosten-/Mengen-Strukturen.

Zusätzlich gibt die Analyse der Verbrauchsverteilung einen Hinweis auf den zu erwartenden Aufwand und die benötigten Personen. Sind die Verbräuche gleichmäßig über die Applikationen verteilt, oder verbrauchen – wie so häufig – weniger als 5 Prozent der Anwendungen 80 Prozent der Ressourcen? Je weniger Anwendungen im Fokus stehen, umso geringer ist der Aufwand, konkrete Effizienzgewinne zu realisieren.

Je nach Detailtiefe der Daten aus dem IT-Controlling werden durch solche und weitere Analysen bereits erste Hotspots identifiziert. Damit werden wichtige Voraussetzungen für einen Pilot- oder Projektstart, das Staffing und eine Priorisierung geschaffen.

Pilot-Optimierung

Anhand eines passenden Beispiels lassen sich schnell die Potenziale zur Ressourcenschonung unter Beweis stellen. Dabei überzeugt ein guter Pilot über ein hohes, leicht zu hebendes Potenzial in einem Bereich mit begeisterten Mitarbeitenden und löst dabei idealerweise auch noch nebenbei ein länger bestehendes Betriebsproblem (z. B. Batchlaufzeit zu lang für die Nacht) oder Antwortzeitproblem im Online-Betrieb. Spätestens danach sollte das Management überzeugt und bereit sein für den nächsten Schritt.

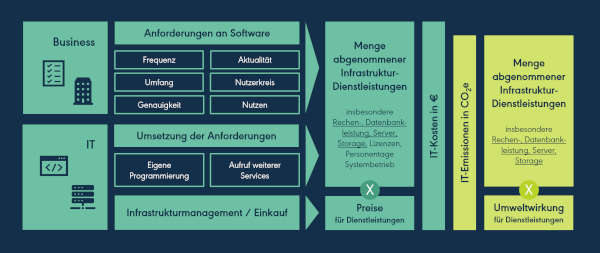

Kernelement eines Piloten und einer Effizienzinitiative sind sogenannte Mengentreiber-Workshops. Sie basieren auf der Tatsache, dass sowohl das Business als auch die IT maßgeblichen Einfluss auf die Menge abgenommener IT-Dienstleistungen haben (siehe Abbildung 5).

Abb. 5: Einfluss von Business und IT auf IT-Kosten und IT-Emissionen (illustrativ)

So wird zunächst technisch analysiert, welche Stellen im Programmcode und dann auch, welche Anforderung einen hohen Infrastrukturbedarf bedingen. Anschließend kann gemeinsam erarbeitet werden, welche Möglichkeiten zur Optimierung bestehen.

Fachlich kann hinterfragt werden, ob die Anforderung noch aktuell ist und ob Teile der Anforderung geändert werden können, zum Beispiel die Frequenz oder der Umfang einer Datenaktualisierung. Auch die Genauigkeit von Berechnungen kann angepasst und gegebenenfalls durch eine effizientere und hinreichend genaue Approximation ersetzt werden. Technisch kann der Aufruf von anderen Services verbessert oder die eigene Programmierung, beispielsweise durch geeignetes Caching, optimiert werden.

Fehlt an dieser Stelle die notwendige Sensibilität der Akteure, reduziert sich das hebbare Effizienzpotenzial gravierend.

Effizienzinitiative

Wird die Entscheidung getroffen, die Senkung von IT-Verbräuchen auf andere Unternehmensteile auszuweiten, lohnt es sich, noch einmal innezuhalten. Hier lauern – wie so oft in IT-Projekten – einige Fallstricke.

Effizienzsteigerungsprojekte bringen immer den mindestens latenten Vorwurf mit, die Verantwortlichen hätten bisher nicht gut gearbeitet. Daher ist es von größter Bedeutung, bereits bei den ersten Gedanken zu so einer Initiative und bei jedem Schritt zu antizipieren, wie dieser bei denen wahrgenommen werden wird, die für die in den Fokus genommene Applikation zuständig oder verantwortlich sind. Auch passende Statements des Managements sind notwendig, um eine glaubhafte und erfolgreiche Effizienzinitiative zu ermöglichen.

Erfolgsfaktoren für eine gelungene Effizienzinitiative

Aus der Erfahrung mehrerer Effizienzinitiativen habe ich die aus meiner Sicht wichtigsten Erfolgsfaktoren zusammengestellt:

Gemeinsam

Beteiligen Sie rechtzeitig alle wesentlichen Stakeholder am Projekt. Auftraggeber sollten repräsentative Verantwortliche aus IT-Controlling, IT und dem IT-nahen Fachbereich sein.

Geben Sie den internen Mitarbeitenden in IT und im Fachbereich die Möglichkeit, selbst – und auf Wunsch zuerst allein – Analysen zu Hotspots durchzuführen. Das fördert die Motivation. Interne Mitarbeitende sind eingearbeitet, kennen Schwachstellen und sind preiswerter als externe Beratungsunternehmen. Die eigene Beschäftigung mit diesem Thema erhöht zudem die Sensibilität und hat damit einen nachhaltig positiven Effekt auf den Einsatz von IT-Ressourcen bei Weiter- und Neuentwicklungen.

Bieten Sie Support von geschätzten Kollegen an. Haben Sie ein zentrales externes IT-Dienstleistungsunternehmen? Binden Sie es und dessen Mitarbeitende so eng wie möglich in die Effizienzinitiative ein.

Nach ersten technischen und fachlichen Überprüfungen helfen interdisziplinäre Mengentreiber-Workshops, die Hotspots technisch und fachlich genau zu lokalisieren und gemeinsam Ideen zur Optimierung zu entwickeln. Begrenzen Sie die Anzahl der Teilnehmenden an diesen Workshops auf 6 bis 8 Personen.

Outside-in-Perspektive

Eine interne Outside-in-Perspektive, zum Beispiel durch einen geschätzten IT-Architect, Lead-Developer oder Business-Consultant für andere Applikationen aus einem anderen Unternehmensteil, ist preiswert und erweitert den Blick des Teams.

Eine externe Outside-in-Perspektive gibt zudem neue Ideen und Best Practices aus anderen Unternehmen. Sie hinterfragt Argumente und Vorschläge, die aus Ihrem Unternehmen aus historischen Gründen niemand mehr hinterfragt.

Schaffen Sie ein Klima der Optimierung und nicht der Rechtfertigung.

Klima der Optimierung

Eine unternehmensfremde Person in der Steuerung kann hier den entscheidenden Vorteil bieten. Ihr wird es am ehesten abgenommen, dass sie kein Interesse an Gründen hat, warum eine Optimierung nicht schon in der Vergangenheit stattgefunden hat. Demnach wird auch keine so große Gefahr gesehen, dass mögliche Unzulänglichkeiten oder sogar als peinlich wahrgenommene Ressourcenverschwendungen im Unternehmen breit diskutiert werden. Schließlich ist es wichtiger, neue kreative, passgenaue Lösungen für noch schlummernde Effizienzpotenziale zu finden.

Überschneidungsfreiheit

Ein erfolgreicher Mengentreiber-Workshop erzeugt Optimierungsvorschläge, die sich gegenseitig ergänzen, ausschließen oder überlagern. Betrachten Sie jeden einzelnen Vorschlag mit Nutzen und Nachteilen (Aufwand, Auswirkungen, …) unabhängig von den anderen. Machen Sie mindestens einen konkreten Vorschlag für ein sinnvolles Paket und bewerten Sie dies erneut. So vermeiden Sie die Ausweisung von Nutzen, der nie additiv gehoben werden kann.

CO2-/Cash-out-Relevanz

Verschiebungen von Emissionen und Kosten sind nichts Ungewöhnliches bei Optimierungsmaßnahmen von Software. Wer beispielsweise Caching einsetzt, um CPU-Bedarfe zu reduzieren, benötigt mehr Speicherplatz. Daher ist es wichtig, dass Sie einen ganzheitlichen Blick auf Ihre Maßnahmen haben.

Dabei ist die Cash-out-Relevanz ebenso wichtig. Schließlich sollen Emissionen und Kosten tatsächlich und nicht nur theoretisch sinken. Eine ausschließliche Verschiebung zwischen Kostenstellen soll vermieden werden.

Stimmen Sie sich rechtzeitig mit dem IT-Infrastrukturbetrieb ab. So können Aktivitäten ergriffen werden, die sicherstellen, dass Ihre Maßnahmen cash-out-relevant werden. So nützt Ihre Arbeit der Umwelt und (!) dem Unternehmen.

Transparentes Monitoring

Ein Projekt zur Reduzierung von IT-Verbrauch wird nie die wichtigste Maßnahme im Unternehmen sein. Berichten Sie regelmäßig, transparent und zentral über den Gesamtfortschritt und den der Einzelmaßnahmen inkl. der Einzelnutzen und der Verantwortlichkeiten. Der sehr konkrete und schnelle Nutzen der Einzelmaßnahmen wird Ihnen bei Priorisierungsentscheidungen helfen.

In der Praxis haben diese Erfolgsfaktoren maßgeblich dazu beigetragen, dass zum Beispiel ein großer deutscher Versicherer signifikant IT-Betriebskosten senken konnte. Im konkreten Projekt musste für € 1 jährliche Einsparungen von IT-Betriebskosten deutlich weniger als € 1 einmaliger Projektaufwand (bei einer Vollkostenrechnung) investiert werden. Das entspricht einem ROI von mehr 10 bei einer üblichen 10-Jahres-Betrachtung.

Fazit

Es gibt mehrere gute Ansätze, sich ressourcenschonender Software oder geringen IT-Kosten zu nähern. Achim Guldner et al. [3] zielen mit dem Green Software Measurement Model (GSMM) darauf ab, die Messung des Software-bedingten Energieverbrauchs zu verbessern.

Ein anderer Bottom-up-Ansatz ist die Durchführung flächendeckender statischer Code-Analysen, zum Beispiel mit dem ALGIT-Ansatz (Assembly Line for Green IT) von metafinanz und Cast. Ziel ist es, typische ineffiziente Codierungen KI-unterstützt zu identifizieren, zu optimieren und Ressourcen einzusparen.

Der in der heutigen Zeit vermutlich berühmteste Top-down-Ansatz, IT-Kosten zu reduzieren, ist FinOps, ein „Framework und eine kulturelle Praxis, die

- den geschäftlichen Nutzen der Cloud maximiert,

- eine zeitnahe datengestützte Entscheidungsfindung ermöglicht und

- durch die Zusammenarbeit von Teams aus Technik, Finanzen und Fachbereich finanzielle Verantwortlichkeit schafft.“ [4]

Einschränkend ist dabei meines Erachtens die Fokussierung auf die Reduzierung von Kosten in der Cloud. Außerdem finden sich Maßnahmen, die den Ressourcenverbrauch und damit auch Emissionen reduzieren würden, erst in fortgeschrittenen Phasen von FinOps.

Der vorgestellte Green-DevOps-Check (inkl. Assessment und Datenanalyse) ist auch ein Top-down-Ansatz und betrachtet dabei alle Emissionen und IT-Kosten, das heißt inklusive On-prem-Lösungen. Er gewichtet Interdisziplinarität hoch – ähnlich wie Fin-Ops – und fokussiert auf Ressourcenschonung durch Software. Der Ansatz hat den Anspruch, das Potenzial schnell sichtbar zu machen. Er soll Unternehmen die Erkenntnis verschaffen, ob und wo Optimierungspotenziale schlummern, und eine schnelle, valide Abschätzung zum Nutzen von Softwareoptimierung ermöglichen. Danach können zielgerichtete automatisierte Bottom-up-Ansätze oder gezielte Performancetunings zur Anwendung kommen. Die Erfahrung zeigt, dass durch Optimierung von Software ein großes Maß an Emissionen und Kosten gesenkt werden kann. Es lohnt sich, diesen bisher vernachlässigten Hebel der Verbrauchsreduzierung stärker zu bedienen.

Das Potenzial, IT-Verbrauch zu reduzieren, ist riesig. Davon profitieren Unternehmen und Umwelt.

Die Voraussetzungen für die Genehmigung solcher Effizienzinitiativen in Unternehmen können mit dem vorgestellten Green-DevOps-Check (Assessment und Datenanalyse) geschaffen werden. Wer es richtig anpackt, wird mit einer Effizienzinitiative gemeinsam mit IT-Controlling, IT und IT-nahem Fachbereich sehr erfolgreich sein und vielleicht sogar in „Goldgräberstimmung“ verfallen. Davon werden Unternehmen und Umwelt profitieren – grüne und günstige Software zum Wohle von Umwelt und Unternehmen. Viel Erfolg!

Weitere Informationen

[1] The Shift Project, Lean ICT: Towards Digital Sobriety, 2019

[2] R. Hintemann, S. Hinterholzer, Steigender Energie- und Ressourcenbedarf der Rechenzentrumsbranche, 2023,

siehe: https://www.borderstep.de/wp-content/uploads/2023/08/Borderstep_Rechenzentren2022_final.pd

[3] A. Guldner et al., Development and evaluation of a reference measurement model for assessing the resource and energy efficiency of software products and components – Green Software Measurement Model (GSMM), 2024, siehe: https://www.sciencedirect.com/science/article/pii/S0167739X24000384

[4] FinOps Foundation, What is FinOps?,

siehe: https://www.finops.org/introduction/what-is-finops/

[5] Gartner Forecasts Worldwide Public Cloud End-User Spending to Surpass $675 Billion in 2024,

siehe:https://www.gartner.com/en/newsroom/press-releases/2024-05-20-gartner-forecasts-worldwide-public-cloud-end-user-spending-to-surpass-675-billion-in-2024