Die wichtigsten News der FabCon 2025

Die Microsoft Fabric Community Conference 2025 (FabCon 2025), die Anfang April in Las Vegas stattfand, brachte eine Vielzahl Neuerungen und Ankündigungen zu Microsofts Datenplattform, insbesondere rund um Power BI und die Integration von Künstlicher Intelligenz in BI-Prozesse:

Copilot und KI-Funktionen für alle Fabric-Nutzer

Copilot, Microsofts KI-gestützter Assistent, steht nun in allen Fabric-Kapazitätsstufen zur Verfügung und ist damit nicht mehr nur für große Unternehmen zugänglich. Power-BI-Anwender können KI-gestützt Berichte erstellen, Daten zusammenfassen und Erkenntnisse generieren, indem sie einfach natürliche Sprache verwenden. Darüber hinaus wurden die neuen KI-Funktionen zu „Fabric Data Agents“ erweitert. Diese KI-basierten Assistenten ermöglichen die Suche und Auswertung von Datenquellen per natürlicher Sprache – auch ohne tiefgehende technische Kenntnisse.

Echtzeit-Intelligenz und Translytical Reporting

Neue Funktionen ermöglichen nahezu Echtzeit-Analysen in Power BI, etwa durch eine bessere Integration von SAP-Daten und anderen Unternehmensquellen. Mit Hilfe von Translytical Reporting können Werte direkt in Power-BI-Berichten angepasst und anschließend in die Fabric-Data-Warehouse-Tabellen zurückgeschrieben werden. Das ist insbesondere für die Finanzplanung und das Forecasting von großer Bedeutung.

Verbesserte Datenintegration und Interoperabilität

Microsoft setzt auf eine offene, interoperable Plattform: Ein neues Partnerschaftsmodell mit Snowflake erlaubt es, Iceberg-Tabellen zwischen Fabric und Snowflake ohne Datenmigration zu lesen. Des Weiteren wird der Migrationsprozess von Azure Synapse zu Fabric Data Warehouse vereinfacht, was Unternehmen den Umstieg erleichtert.

Zentrale Sicherheit und Governance

Die Einführung eines zentralisierten Sicherheitsmodells (OneLake Security) vereinfacht die Verwaltung und schützt Daten umfassender – ein wichtiger Aspekt für BI- und Analytics-Teams. Microsoft Purview bietet neue Funktionen, die die Data Governance, die Compliance und das Management von Zugriffsrisiken verbessern.

Effizienzsteigerung für Daten- und BI-Teams

Pipelines können jetzt durch Dateiänderungen in OneLake automatisch ausgelöst werden, was eventgetriebene Datenprozesse vereinfacht. Die Funktion Incremental Refresh steht nun in Dataflow Gen2 zur Verfügung. Dadurch werden nur neue oder geänderte Daten verarbeitet, was zu einer Steigerung der Performance bei großen Datenmengen führt.

Zu den weiteren Highlights gehören der direkte Zugriff auf große Sprachmodelle für BI-Analysen und Daten-Pipelines dank Native Azure OpenAI-Integration und ein flexibleres Kostenmodell für Spark-Workloads.

PLM-Systeme entwickeln sich zum Datenhub

Auf der diesjährigen Hannover Messe wurde ein deutlicher Fortschritt bei der Implementierung von KI in der Industrie deutlich. Im Gegensatz zu den Vorjahren wurde von den Ausstellern vermehrt auf die Präsentation von praxisnahen Lösungen mit konkretem Nutzen statt auf theoretische Konzepte gesetzt. Dr. Gero Presser, CEO von Dataciders, betont die Notwendigkeit für Unternehmen, ihre Daten effizienter zu organisieren und zu nutzen, um die Potenziale von PLM-Systemen als zentrale Datenhubs für die gesamte Wertschöpfungskette voll auszuschöpfen. Im Zuge dieser Transformation verschmelzen die Grenzen zwischen klassischer IT und Industrietechnik zunehmend. Trotz des großen Interesses an KI-Projekten bleibt die Implementierung eine Herausforderung. Hans-Georg Prädelt, Geschäftsführer von Dataciders redpoint. teseon, betont die Notwendigkeit einer klaren Roadmap und soliden Datenstrategie, um langfristigen Erfolg zu gewährleisten. Die Messe bestätigte den Trend: KI, durchgängiges Datenmanagement und PLM werden zu Schlüsselfaktoren für die industrielle Zukunft. Unternehmen müssen diese Technologien strategisch einsetzen, um wettbewerbsfähig zu bleiben (https://dataciders.com/en/unternehmensnews/hannover-messe-2025-ki-supply-chain-product-lifecyclemanagement/).

Data Excellence: Studie belegt messbare Vorteile für Unternehmen

Data Excellence zahlt sich aus: Zu diesem Ergebnis kommt eine aktuelle Studie des Beratungsunternehmens dataspot in Zusammenarbeit mit der FH Campus Wien. Die Befragung von 144 Datenexperten liefert empirische Belege für den praktischen Nutzen eines strategischen Datenmanagements.

Demnach profitieren Unternehmen auf vielfältige Weise von strukturierter „Data Excellence“. Besonders deutlich wird der Effekt bei Effizienz und Produktivität: Im Schnitt berichten die Studienteilnehmer von einer Kostenreduktion um 47 Prozent und einer Zeitersparnis von 54 Prozent bei Datenprojekten. Als Hauptgründe für die Einführung eines professionellen Datenmanagements werden von den Befragten insbesondere die Notwendigkeit genannt, die Kontrolle über die stetig wachsenden Datenbestände zu wahren. Es wurde betont, dass das volle Potenzial von Daten nur durch klar definierte Prozesse und Verantwortlichkeiten ausgeschöpft werden kann. Die 46-seitige Studie liefert zudem Erkenntnisse zu den häufigsten Anwendungsfällen von Data Excellence, den größten Hindernissen in der Praxis sowie zur Bedeutung einer datengetriebenen Unternehmenskultur. Für die Mehrheit der Experten steht fest: Ohne Data Excellence wird es künftig kein erfolgreiches Wirtschaften mehr geben. Interessenten können die Studie nach Angabe ihrer Kontaktdaten kostenlos auf der Website von dataspot. herunterladen: https://www.dataspot.at/outcome/

Die Synergie von Künstlicher Intelligenz und Quantencomputing

Quantencomputer verlassen zunehmend die Labore und werden in ersten realen Anwendungen bei Unternehmen und in Rechenzentren eingesetzt. Um diese Entwicklung weiter voranzutreiben, soll durch die Kombination von KI und Quantencomputing die Lücke zwischen theoretischem Potenzial und praktischer Anwendung geschlossen werden. Das Fraunhofer-Institut für Integrierte Schaltungen IIS und SAP arbeiten daran, KI in diesem Bereich zu nutzen. Die Kombination von KI und Quantencomputing nutzt speziell auf Quantencomputer zugeschnittene KI-Modelle, um das volle Potenzial der Quantenhardware auszuschöpfen und bisher unlösbare Probleme zu bewältigen. KI wiederum kann den komplexen Zugang zur Programmierung von Quantencomputern erleichtern. Bisher setzt die Programmierung noch ein tiefes Verständnis der Quantenmechanik voraus. Für BI-Systeme erhofft man sich aus der Synergie beider Techniken eine Vielzahl neuer Möglichkeiten:

- Präzisere und schnellere Vorhersagemodelle für geschäftskritische Entscheidungen durch neue Algorithmen

- Nutzung robusterer Modelle, die auch bei verrauschten oder unvollständigen Geschäftsdaten funktionieren

- Lösung komplexer Probleme aus Logistik- und Ressourcenoptimierung

- Verarbeitung bislang für BI nicht zu bewältigender Datenmengen

- Schnellere Datenverarbeitung für den Einsatz von Echtzeit-BI, auch bei geografisch getrennten Datenquellen

- Ressourceneffizientere Implementierungen, die den Einstieg in Quantum-BI auch für mittelständische Unternehmen erschwinglich machen

Die Experten von Fraunhofer konzentrieren sich auf fortschrittliche Quantenalgorithmen für Simulation, Optimierung und maschinelles Lernen. Durch Methoden wie „Quantum Circuit Cutting“ sollen auch komplexe Berechnungen auf heutige Quantencomputer verteilt werden können. Ein weiterer Schwerpunkt ist die Quantenfehlerkorrektur, um Systeme robuster und skalierbarer zu machen. Die Forschungsarbeiten des Fraunhofer IIS zeigen deutlich, dass der duale Ansatz – die Verbesserung heutiger und die Vorbereitung zukünftiger Quantenhardware durch KI – entscheidend ist, damit Quantencomputing sein Versprechen einlösen kann, Branchen, Wissenschaft und Technologie nachhaltig zu transformieren.

SAP hingegen hat die Entwicklung von KI-Modellen im Visier, die speziell auf die Prinzipien des Quantencomputings wie Superposition und Verschränkung ausgelegt sind. Durch quantenoptimierte KI-Architekturen sollen sich völlig neue Möglichkeiten für Entscheidungsprozesse und Optimierungen ergeben. Bis zur Marktreife will SAP auf hybride Ansätze setzen, die klassische KI und Quantencomputing kombinieren. Eine Hürde für den breiten Einsatz von Quantencomputern ist bislang, dass für die Programmierung Spezialkenntnisse nötig sind. SAP will dieses Problem durch generative KI lösen, die Quantencode automatisch erstellen kann. So sollen auch Nicht-Experten Quantencomputer für Optimierungsaufgaben nutzen können.

Edge-Computing: Nachfrage durch Industrie 4.0 boomt

Die Marktanalyse der IMARC Group prognostiziert für den globalen Edge-Computing-Markt ein Wachstum von 18,3 Mrd. USD im Jahr 2024 auf 114 Mrd. USD bis zum Jahr 2033, bei einer jährlichen Wachstumsrate von 22,4 Prozent. Die Entwicklung wird insbesondere durch die Einführung von Industrie 4.0, also die Digitalisierung und Automatisierung der Industrie, vorangetrieben. Der Grund dafür ist, dass die Industrie verstärkt in Edge-Computing-Lösungen investiert, um Produktionsdaten lokal zu verarbeiten und Latenzzeiten zu minimieren. Insbesondere im Kontext von IoT und Smart Manufacturing gewinnen hybride Edge-Cloud-Architekturen an Bedeutung. Edge Computing und hybride Edge-Cloud-Architekturen sind wesentliche technologische Grundlagen für die Echtzeit-Datenverarbeitung und -analyse in modernen Produktionsumgebungen. Sie sind ein entscheidendes Instrument für Unternehmen, um große Mengen an Produktions- und Sensordaten effizient zu erfassen, schnell auszuwerten und unmittelbar verwertbare Erkenntnisse für das operative Geschäft abzuleiten. Dies ist ein Kernelement von Business Intelligence in der Industrie 4.0.

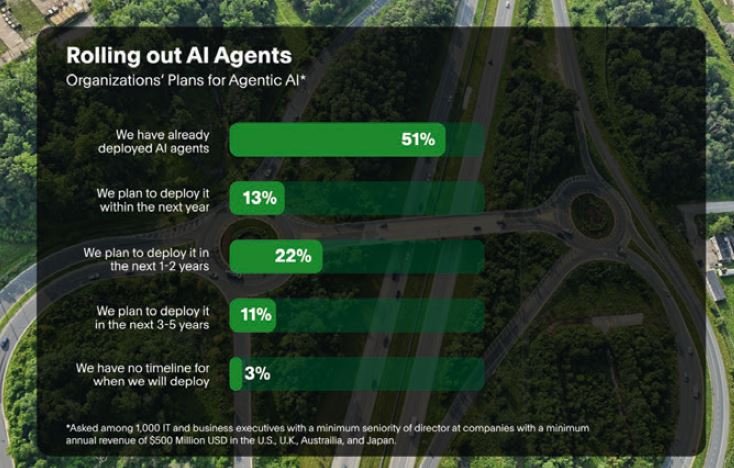

Agentic AI wird zum Standard

Laut dem PagerDuty-Report 2025 setzen viele Unternehmen bereits KI-Agenten (Agentic AI) ein. Laut diesem Bericht, für den mehr als 1.000 IT- und Business-Entscheider aus der ganzen Welt befragt wurden, haben 51 Prozent der Unternehmen weltweit bereits KI-Agenten im Einsatz. Besonders groß ist der Anteil in Asien und Nordamerika. Bis 2027 erwarten 86 Prozent der Unternehmen, mit solchen Agenten zu arbeiten.

Zwar liegt der Hauptfokus des Reports auf der Verwendung von Agentic AI für IT Operations, dennoch wurden auch Auswirkungen auf andere Abteilungen und die gesamte Organisation betrachtet, etwa in Bezug auf Produktivität, ROI und die Veränderung von Arbeitsabläufen durch KI-Agenten. Für Business Intelligence ist der Einsatz von KI-Agenten erfolgversprechend, um Daten zu analysieren, Muster zu erkennen, Vorhersagen zu treffen und Entscheidungsprozesse zu automatisieren. KI-Agenten in BI-Anwendungen ermöglichen beispielsweise die automatisierte Erstellung von Berichten, die Erkennung von Trends oder die Beantwortung von Analysefragen in natürlicher Sprache.