Komplexere Zusammenhänge werden in Erklärungen häufig stark vereinfacht und spiegeln unzureichend die Realität wider. Dies führt dazu, dass ähnliche oder sogar gleiche Sachverhalte unterschiedlich entschieden werden, wodurch Inkonsistenzen entstehen.

Erklärbare künstliche Intelligenz ermöglicht es, komplexe Zusammenhänge zu lernen und menschlichen Entscheidern als Handlungsempfehlung zur Verfügung zu stellen. Handlungsempfehlungen unterstützen somit verantwortungsbewusst den Menschen, anstatt dass KI die Entscheidungshoheit übernimmt.

Handlungsempfehlungen in Fachdomänen

Eine Handlungsempfehlung ist ein Vorschlag für eine Entscheidung über einen fachlichen Sachverhalt – mit der Angabe von Gründen, ohne die Entscheidung automatisiert durchzuführen. Als Beispiel soll ein vereinfachter Sachverhalt über den Versicherungsfall eines KFZ-Glasbruchs aus der Praxis dienen. Dabei geht es um den Austausch der Windschutzscheibe eines VW Golf V, Baujahr 2008, Modell „Edition 30“ mit einem Kostenvoranschlag von 934 €. Dieser wird als Tupel dargestellt [‚VW Golf V‘, ‚Edition 30‘, ‚2008‘, ‚934 €‘].

Im konkreten Anwendungsfall werden neben Hersteller, Baujahr und Modell weitere Merkmale wie Laufleistung, Werkstatt, Regionen hinzugezogen, die ebenfalls entscheidungsrelevant und damit Bestandteil einer Handlungsempfehlung sind. Eine extrahierte Handlungsempfehlung könnte lauten: „Reduktion auf 810 €, da die Kosten des Austauschs einer Windschutzscheibe PKW dieses Modells in der Region Münster zwischen 390 und 810 € betragen.“

Die letztendliche Entscheidung trifft somit ein Mensch. Wichtig zu beachten ist, dass unterschiedliche Menschen (oder bei sich wiederholender Entscheidung gar dieselbe Person) unterschiedliche Entscheidungen treffen. Trifft dieser Fall zu, liegt eine inkonsistente Entscheidung vor. Deterministische und präzise Handlungsempfehlungen bieten einen Ankerpunkt, um mehr Konsistenz herbeizuführen.

Zusätzlicher Gewinn: Wird der Handlungsempfehlung gefolgt oder eben nicht, liegt ein weiterer Datensatz vor. Dieser wird beim nächsten Lernen zur weiteren Präzision der KI-Entscheidungen genutzt. Die Entscheidungskomponenten optimieren sich gegenseitig.

Unverantwortlich: die Vollautomatisierung von Geschäftsentscheidungen

Der Einsatz von KI wird häufig gleichgesetzt mit der Vollautomatisierung vieler, wenn nicht aller, manueller Tätigkeiten. In der Praxis zeigt sich, dass einer Automatisierung von fachlichen Entscheidungen, wie einer Kreditvergabe oder Versicherungsfreigabe, natürliche Grenzen in Form von gesetzlichen Vorschriften, Datenschutz und weiteren Gründen gesetzt sind.

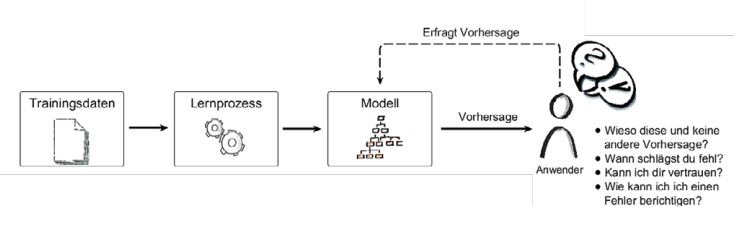

Diese Grenzen ergeben sich durch den Blackbox-Charakter einer KI, die auf Maschinellem Lernen (ML) basiert. Ein Blackbox-Modell beschreibt den Umstand, dass ML zwar Muster in Daten identifizieren und anwenden, jedoch keine Aussage über Kausalität geben kann, wie Abbildung 1 veranschaulicht.

Mit Expertenwissen ist zwar zu beurteilen, ob einzelne Blackbox-Entscheidungen in Bezug auf den jeweiligen Sachverhalt sinnvoll sind, allerdings können weder Domänen- noch KI-Experten mit Sicherheit sagen, ob das Modell sinnvolle Muster des Sachverhalts anwendet. Eine fachliche Entscheidung in die grundsätzliche Verantwortung einer Blackbox zu geben ist daher bestenfalls fahrlässig.

Abb. 1: Intransparenz einer KI-Blackbox

Löst erklärbare KI das Verantwortungsproblem?

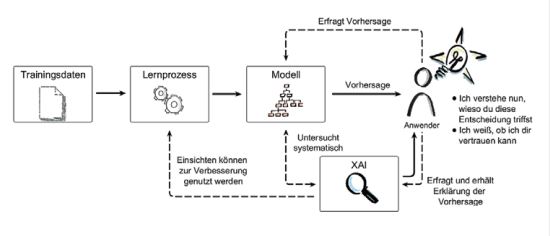

Erklärbare künstliche Intelligenz (oder Explainable Artificial Intelligence, kurz XAI) versucht die Blackbox-Problematik zu lösen, indem ein KI-Modellsystematischen Analysen unterzogen wird, welche die Entscheidungsregeln des Modells extrahieren. Das Extrakt hat den Anspruch, durch Menschen verstanden zu werden, und hilft, Vertrauen gegenüber der KI aufzubauen sowie die Qualität und Nachvollziehbarkeit zu steigern, wie Abbildung 2 verdeutlicht.

Abb. 2: Anspruch von XAI-Verfahren an Transparenz

XAI-Verfahren sind in der Regel Modell-agnostisch[1]. Dies bedeutet, dass das zu erklärende Modell nur von außen bzgl. seines In- und Outputs betrachtet wird, was vor allem für das heutige automatisierte und komplexe ML (AutoML)[2] unerlässlich ist.

Zudem unterteilen XAI-Verfahren sich in lokale und globale Erklärer. Eine lokale Erklärung gibt eine Rechtfertigung für eine Einzelentscheidung wieder, beispielsweise zur Handlungsempfehlung für den einleitend genannten Versicherungsfall, welcher speziell auf ein KFZ bezogen ist. Eine globale Erklärung beschreibt dagegen das Entscheidungsverhalten des gesamten Modells und liefert Erklärungen für ganze Bereiche der fachlichen Domäne, wie noch gezeigt wird.

Ein Beispiel für ein lokales XAI-Verfahren ist Anchors[3], das einfach zu verstehende Wenn-Dann-Beziehungen aus Blackboxen extrahiert. Wird Anchors zusammen mit dem Algorithmus Coverage Pick[4] angewendet, liefert das Verfahren nicht nur lokale, sondern auch globale Erklärungen. Für das Beispiel „KFZ-Glasbruch“ könnte die Erklärung lauten:

„Wenn das KFZ Modell aus der Menge „Golf IV“, „Golf V“, „Golf VI“ stammt, das Baujahr zwischen 2000 und 2010 liegt und der Preis 820 € übersteigt, dann ist der Kostenvoranschlag entsprechend zu reduzieren.“

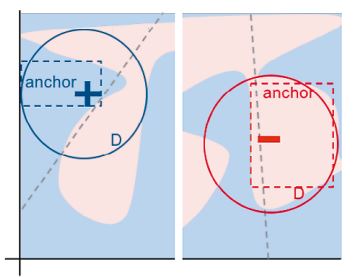

Das zugrundeliegende Verfahren von Anchors versucht, Grenzen zwischen Entscheidungsübergängen zu identifizieren. In Abbildung 3 ist die von Anchors gefundene Entscheidungsgrenze als rot bzw. blau gestrichelte Box dargestellt und der untersuchte Einzelfall als blaues Plus bzw. rotes Minus. Der jeweils gestrichelte Kasten zeigt den Bereich, für den eine gültige Erklärung gefunden wurde.

Abb. 3: Entscheidungsgrenzen von Anchors[5]

Der Algorithmus Anchors verwendet zur Analyse einer Einzelentscheidung Pertubationen des Sachverhalts. Der Sachverhalt wird leicht verändert, indem einzelne Merkmale mit Werten aus dem Lösungsraum ersetzt werden. Der Lösungsraum für „KFZ-Glasbruch“ umfasst weitere KFZ-Modelle anderer Hersteller. Für den Versicherungsfall [‚VW Golf V‘, ‚Edition 30‘, ‚2008‘, ‚934 €‘] ist eine mögliche Pertubation beispielsweise [‚Skoda Fabia‘, ‚Scout‘, ‚2008‘, ‚934 €‘], wobei die Merkmale Baujahr und Kostenvoranschlag fixiert sind. Anchors erzeugt eine Klassifikation mit dem zu analysierenden Blackbox-Modell und prüft, ob sich die Klassifikation verändert hat. Ist die Klassifikation unverändert, dann nimmt der Coverage-Pick das Modell „Skoda Fabia Scout“ mit in die Erklärung auf.

Bei einfachen Domänen mit wenigen Merkmalen sind XAI-Erklärungen sehr präzise. Wächst der Lösungsraum um weitere Merkmale und Daten, ist eine exakte Interpretation einer Blackbox nicht praktikabel. Dann muss zwischen Erklärbarkeit und Effizienz abgewogen werden[6].

Handlungsempfehlungen in „intelligenten“ Prozessen

Ist ein Geschäftsprozess teilweise oder vollständig automatisiert, lassen sich Prozessentscheidungen durch KI-Modelle automatisieren. Handlungsempfehlungen beschleunigen dabei die menschliche Entscheidung und sichern deren Konsistenz. Letzteres bietet einen nachhaltigen Ansatzpunkt für schnelle und risikoarme Integration von KI und erleichtert es, Prozessaufwände zu minimieren und dabei Risiken wie Concept Drift implizit zu begegnen[7].

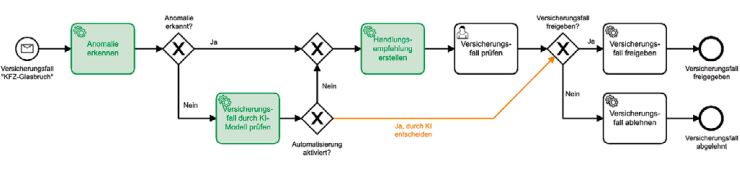

Abbildung 4 zeigt den Versicherungsprozess KFZ-Glasbruch in vereinfachter Form. Der Eingang eines Versicherungsfalls initiiert den Prozess. Anschließend wird der Versicherungsfall einer Anomalieerkennung unterzogen und, falls es sich um eine Anomalie handelt, zur Handlungsempfehlung weitergeleitet. Handelt es sich nicht um eine Anomalie, wird ein KI-Modell eine Entscheidung über Annahme oder Ablehnung des Versicherungsfalls treffen. Der Prozessfluss folgt dem Gateway „Automatisierung aktiviert“ auf dem Pfad „Nein“, so dass beide KI-Tasks in der Task „Handlungsempfehlung erstellen“ münden. Anschließend wird der Versicherungsfall einer manuellen Prüfung unterzogen, welche eine maßgeschneiderte Handlungsempfehlung enthält.

Abb. 4: Geschäftsprozess KFZ-Glasbruch mit integrierten KI- und XAI-Modellen

Die grün gekennzeichneten Tasks verwenden KI-Verfahren und werden in Hinblick auf die Handlungsempfehlung gesondert betrachtet. Zur Vollständigkeit zeigt der orange gefärbte Prozessfluss eine mögliche Automatisierung der KI-Entscheidung, die eine explizite Prüfung überspringt. Eine verantwortungsvolle Vollautomatisierung stellt spezielle Anforderungen an einen intelligenten Prozess[8].

Handlungsempfehlungen für Anomalien

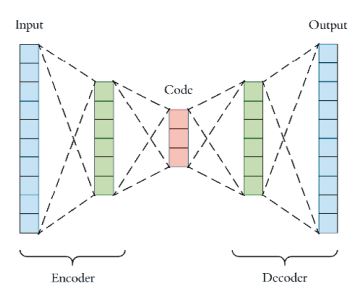

Eine Anomalieerkennung identifiziert sehr seltene Sachverhalte auf Basis der historischen Daten. Gängige Anomalieverfahren sind Deep-Learning-Autoencoder[9], die ebenfalls mit den historischen Daten trainiert werden.

Autoencoder versuchen, die Merkmale eines Sachverhalts zu komprimieren und wieder zu dekomprimieren, mit dem Ziel, wieder dieselben Merkmale zu erhalten. Abbildung 5 zeigt als Input die zu komprimierenden Merkmale und als Output das Ergebnis der Dekomprimierung.

Das Tupel [‚VW Golf V‘, ‚Edition 30‘, ‚2008‘, ‚934 €‘] wird in einen Vektor transformiert, um als Input für Autoencoder zu dienen. Der dekomprimierte Ergebnisvektor (Output) wird mit dem Input verglichen, wobei die Differenz beider Vektoren Informationen dazu liefert, welche Merkmale für die Anomalie verantwortlich sind. In diesem Fall kommt XAI zum Tragen und erklärt durch sogenannte „Counterfactual“- Erklärung[10], welche Ausprägungen des Leistungsantrags eine Anomalie erzeugen und unter welchen Umständen ein Normalfall vorliegen würde. Diese Transparenz erleichtert die manuelle Prüfung, da die zur Anomalie führenden Merkmale unmittelbar sichtbar sind. Weiterhin schafft der Vergleich der Merkmale einer Anomalie und eines naheliegenden Normalfalls eine Entscheidungsunterstützung für seltene Geschäftsvorfälle.

Abb. 5: Autoencoder

Empfehlungen in Routineentscheidungen

Sollte der Antrag nicht als Anomalie erkannt werden, trifft das KI-Modell eine Entscheidung über den jeweiligen Sachverhalt. Im Fall von KFZ-Glasbruch klassifiziert es den Versicherungsfall in „Annahme“ oder „Ablehnung“. Anschließend wird auf Basis der Anchors- und Coverage-Pick-Analyse eine Handlungsempfehlung erzeugt und in geeigneter Form zur Entscheidungsunterstützung zur Verfügung gestellt. Die Empfehlung umfasst die Merkmale und deren Beziehung zueinander, inklusive der historischen Daten. Somit werden die von einer KI erkannten Zusammenhänge transparent. Anstatt nun den gesamten Geschäftsfall zu überdenken, werden Menschen direkt zu Beginn auf die relevanten Merkmale aufmerksam gemacht, was eine konsistente und beschleunigte Bearbeitung ermöglicht.

Fazit

Handlungsempfehlungen auf Basis erklärbarer KI können selbst komplexe Entscheidungsmuster in für Menschen verständlicher Form zur Verfügung stellen. Diese Handlungsempfehlungen helfen, sowohl Fehlentscheidungen als auch Entscheidungsaufwände zu minimieren, ohne dabei Risiken vollautomatischer Entscheidungen einzugehen.

Es wird also ein bisher unauflösbar geglaubter Kompromiss gelöst, der dem effizienten KI-Einsatz im Wege stand. Hierfür wird auf eine menschliche Prüfung zurückgegriffen, die Unsicherheiten aufklären kann. Handlungsempfehlungen beschleunigen somit Geschäftsprozesse und sorgen für mehr Konsistenz, ohne sich auf riskante Blackbox-Entscheidungen zu verlassen. In jedem Fall behält der Mensch die Kontrolle über den Prozess und die finale Entscheidung. Fällt diese anders aus, so kann die Entscheidung zur Korrektur des KI-Modells genutzt werden.

Literatur & Links

[1] Christoph Molnar (2020), Interpretable Machine Learning, https://christophm.github.io/interpretable-ml-book/agnostic.html

[2] Julien Jouganous, Romain Savidan and Axel Bellec (2018), A brief overview of Automatic Machine Learning solutions (AutoML), https://hackernoon.com/a-brief-overview-of-automatic-machine-learning-solutions-automl-2826c7807a2a

[3] Tobias Goerke, Magdalena Lang (2019), Scoped Rules (Anchors), https://christophm.github.io/interpretable-ml-book/anchors.html

[4] Tobias Goerke (2018), Analyzing and Extending Anchors: A Model-Agnostic Machine Learning Explanation Approach, https://drive.google.com/file/d/1b93x6mpkkFOD7NDV7ZMnpYD5op1T11qd/view

[5] Ribeiro, Singh, and Guestrin (2018), https://www.aaai.org/ocs/index.php/AAAI/AAAI18/paper/view/16982/15850

[6] Cassie Kozyrkov (2018), Explainable AI won’t deliver. Here’s why. https://hackernoon.com/explainable-ai-wont-deliver-here-s-why-6738f54216be

[7] Sushrut Shendre (2020), Model Drift in Machine Learning, https://towardsdatascience.com/model-drift-in-machine-learning-models-8f7e7413b563

[8] Benjamin Wolters (2019), Intelligente Geschäftsprozesse, https://blog.viadee.de/intelligente-geschaeftsprozesse

[9] Arden Dertat (2017), Applied Deep Learning: Autoencoders, https://towardsdatascience.com/applied-deep-learning-part-3-autoencoders-1c083af4d798

[10] Sandra Wachter, Brent Mittelstadt, Chris Russell (2017), Counterfactual explanations without opening the black box: Automated decisions and the GDPR