Wer hat sich nicht schon darüber geärgert, dass ein KI-System dümmer ist als gebraucht? Wenn es falsche Entscheidungen trifft, den Kontext nicht versteht, schwer begreift oder aus Korrelationen falsche Schlüsse zieht? Mein intelligenter Übersetzer versteht nicht ausreichend, in welchem Kontext der englische Text das Wort „term“ verwendet, und bringt immer wieder „Begriff“, „Semester“, „Zahlungsfrist“ und „Amtszeit“ durcheinander. Mein Kollisionssystem im Fahrzeug schlägt wiederholt Alarm, wenn ich an einer Fußgängerinsel vorbeifahre. Wir lesen andererseits entsetzt darüber, dass ein autonom gefahrenes Fahrzeug eine unachtsam die Straße überquerende Radfahrerin nicht als Person erkannt und überfahren hat [Qua19]. Und ärgern uns, wenn ein KI-System aus statistischen Korrelationen einen falschen kausalen Zusammenhang ableitet, der moralisch verwerflich ist, zum Beispiel Frauen diskriminiert [Das18]. Wir erwarten also explizit oder implizit eine gewisse Intelligenz von unserem KI-System, und wollen den Grad bewerten, in dem diese Erwartung erfüllt wird.

Die intrinsische Seite der Softwarequalität

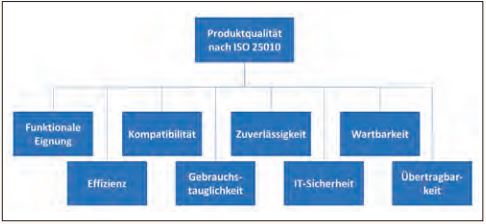

„Man kann nicht steuern, was man nicht messen kann“ – dieses Ingenieursprinzip ist auch in der Softwaretechnik seit jeher verbreitet [DeM82]. Softwaretestern vertraut ist das Modell für Produktqualität der ISO-Normenserie „SQuaRE“ [ISO25010]. Dieses Qualitätsmodell betrachtet schwerpunktmäßig das Softwareprodukt (fast) allein und untergliedert die Produktqualität in verschiedene intrinsische Merkmale (siehe Abbildung 1).

Abb. 1: Merkmale der Produktqualität nach ISO 25010

Schauen wir uns die Definitionen dieser Qualitätsmerkmale an [GTB], dann fällt auf, dass sie alle dem gleichen Satzaufbau folgen: „Der Grad, zu dem eine Komponente oder ein System (bestimmte Anforderungen erfüllt)“. Das Testen dieser Qualitätsmerkmale ist eine Verifizierung: die Bestätigung durch Bereitstellung eines objektiven Nachweises, dass festgelegte Anforderungen erfüllt worden sind.

Die Produktqualität von KI-Systemen

Die Qualitätsmerkmale aus Abbildung 1 sind für jede Art von Software relevant. Aber sie reichen bei KI nicht aus. Wir sind mit einem KI-System erst zufrieden, wenn es auch die nötige Intelligenz aufweist. Ich erwarte nicht, dass unsere Community auf Anhieb den Standard für diese Modellerweiterung findet. Dies ist auch beim bisherigen Softwarequalitätsmodell nicht der Fall gewesen. Aber es gibt bereits Vorschläge für die Erweiterung, wie das von Sogeti [Mar20], welches unter anderem ein Hauptmerkmal „intelligentes Verhalten“ einführt und in folgende Untermerkmale gliedert: Lernfähigkeit, Improvisation, Transparenz, Zusammenarbeit und natürliche Interaktion. Für diese brauchen wir auch neue Definitionen. Hier sind ein paar beispielhafte Vorschläge

- Intelligenz: Der Grad, zu dem ein System Erfahrungen sammeln und diese in gegebenen Situationen sinnvoll anwenden kann.

- Lernfähigkeit: Das Verhältnis des Zugewinns an Intelligenz zum dafür benötigten Aufwand.

- Improvisation: Der Grad, zu dem sich ein System bei neuartigen Situationen erfolgreich Verhalten kann.

- Transparenz: Der Grad, zu dem ein System seine getroffenen Entscheidungen anderen nachvollziehbar begründen kann.

- Zusammenarbeit: Der Grad, zu dem das System das Verhalten von Menschen richtig interpretiert.

- Natürliche Interaktion: Der Grad, zu dem die Kommunikation des Systems mit dem Menschen der natürlichen menschlichen Kommunikation gleicht.

Die subjektive Seite der Softwarequalität

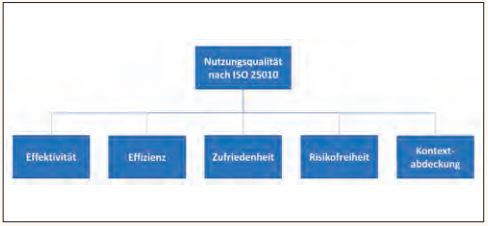

Qualität hat auch eine andere, subjektive Seite: die Nutzungsqualität. Dabei wird das Gesamtsystem aus Softwareprodukt und den Stakeholdern betrachtet. Wir bewerten diese Qualität durch eine Validierung, das heißt, wir stellen fest, ob die Bedürfnisse der Stakeholder für einen spezifischen beabsichtigten Gebrauch oder eine spezifische beabsichtigte Anwendung erfüllt worden sind [GTB]. Das [ISO25010] untergliedert sie in fünf Qualitätsmerkmale (siehe Abbildung 2).

Abb. 2: Merkmale der Nutzungsqualität nach ISO 25010

Im Gegensatz zur Produktqualität kennt die Nutzungsqualität „keine Bewertung mit Punkten oder Schulnoten“, sie ist aber für Stakeholder oft wichtiger [Lud18].

Die Nutzungsqualität von KI-Systemen

Braucht auch die Nutzungsqualität eine Ergänzung bei KI-Systemen? In diesem Zusammenhang werden oft Asimovs Robotergesetze erwähnt [Asi85]. In hierarchischer Kurzform handelt es sich um folgende Anforderungen:

- Gesetz 0: Ein Roboter darf die Menschheit nicht verletzen.

- Gesetz 1: Ein Roboter darf keinen Menschen verletzen.

- Gesetz 2: Ein Roboter muss den Befehlen der Menschen gehorchen.

- Gesetz 3: Ein Roboter muss seine eigene Existenz schützen.

Die Zuordnung dieser Gesetze zum Softwarequalitätsmodell SQuaRE müssen wir differenziert betrachten. Gesetze 0 und 1 könnten wir in der Nutzungsqualität unter Risikofreiheit einordnen, wie den Autounfall des autonomen Fahrsystems [Qua19]. Denn Risikofreiheit ist der Grad, zu dem eine Komponente oder ein System das potenzielle Risiko für den wirtschaftlichen Status, Lebewesen, Gesundheit oder die Umwelt mindert [GTB]. Gesetz 2 wäre eher Teil des KI-Produktmerkmals Zusammenarbeit; Gesetz 3 ist neu, aber auch eher ein Produktmerkmal – ein Untermerkmal der Zuverlässigkeit. Also insgesamt nicht viel Neues.

Ganz anders steht es um die Gerechtigkeit (englisch: Fairness). Dieses in der KI vieldiskutierte Qualitätsmerkmal ist sehr relevant [Bel19]. Gerechtigkeit gehört eindeutig zur Nutzungsqualität, weil sie kulturabhängig ist. In vielen Situationen, wie zum Beispiel bei der Bewertung von neuen Mitarbeitern, ist die Ungerechtigkeit sogar eine illegale Diskriminierung [Das19]. Hier ist ein Definitionsvorschlag:

- Gerechtigkeit: Die Freiheit des Softwareverhaltens von voreingenommenen Entscheidungen und Diskriminierung.

Es ist interessant zu beobachten, dass in der KI-Fachwelt bei diesem Qualitätsmerkmal eine kontroverse Diskussion über ihre Definition und Messung entstanden ist. Mindestens 21 verschiedene Formeln sind vorgeschlagen worden, die auch unterschiedliche Aspekte bewerten [Nar18]. Der wahre Grund dieser Kontroversen ist, dass die Autoren die Nutzungsqualität mit Produktqualität verwechseln.

Fazit

Das klassische Modell der Softwarequalität muss für KI-Systeme erweitert werden. Am einfachsten erfolgt das durch Hinzufügen neuer Merkmale. Erste Modelle gibt es schon.

Auch KI-Qualitätsmodelle sollten zwischen den zwei Sichten auf die Qualität differenzieren: der objektiven Sicht der Produktqualität und der subjektiven Sicht der Nutzungsqualität. Neue Qualitätsmerkmale sollten diese Differenzierung berücksichtigen.

Die Definitionen von neuen Produktqualitätsmerkmalen sollten dem Satzaufbau folgen: „Der Grad, zu dem ein System (bestimmte Anforderungen erfüllt).“ Hingegen können Merkmale der Nutzungsqualität auch Anforderungen enthalten, die nicht „mit Punkten oder Schulnoten“ bewertet werden.

Referenzen

[Asi85] I. Asimov, Das galaktische Imperium, Heyne Taschenbuch, 1985

[Bel19] R. K. E. Bellamy et al., Think Your Artificial Intelligence Software Is Fair? Think Again, in: IEEE Software, July/August 2019, pp. 76-80

[Das18] J. Dastin, Amazon scraps secret AI recruiting tool that showed bias against women, Reuters, Oct. 9, 2018, siehe: https://www.reuters.com/ article/us-amazon-com-jobs-automation-insight/amazon-scraps-secret-ai-recruiting-tool-that-showed-bias-against-women-iduskcn1mk08g

[DeM82] T. DeMarco, Controlling Software Projects: Management, Measurement, and Estimates, Prentice Hall, 1982

[GTB] ISTQB®/GTB Standardglossar der Testbegriffe, siehe: https://www.german-testing-board.info/lehrplaene/istqbr-certified-tester-schema/glossar/

[ISO25010] ISO/IEC Standard 25010. Systems and software engineering – Systems and software Quality Requirements and Evaluation (SQuaRE) – System and software quality models, 1st Edition, 2011 › [Lud18] J. Ludewig, Softwarequalität zwischen hohem Ziel und hohler Floskel, in: A. Spillner et al.: Test, Analyse und Verifikation von Software gestern, heute, morgen. Dpunkt.verlag, 2018

[Mar20] R. Marselis, Auswirkungen von KI auf den Softwaretest, in: OBJEKTspektrum 01/2020

[Nar18] A. Narayanan, Translation tutorial: 21 fairness definitions and their politics, in: ACM Conf. Fairness, Accountability and Transparency, New York, Feb. 2018; s. a. https://www.youtube.com/watch?v=jIXIuYdnyyk

[Qua19] K. Quach, Remember the Uber self-driving car that killed a woman crossing the street? The AI had no clue about jaywalkers, in: The Register, 6.11.2019, siehe: https://www.theregister.co.uk/2019/11/06/uber_self_driving_car_death/