Das Cloud-Datenökosystem ist ein wesentlicher Bestandteil jeder Cloud-Strategie. Unter Cloud-Datenökosystem wird hier eine Plattform verstanden, die Daten von zahlreichen Anbietern kombiniert und durch die Interaktion der verarbeiteten Daten einen Mehrwert schafft. Im Unterschied zum üblichen Datenökosystem kann ein Cloud-Datenökosystem verschiedene Cloud-Architekturen ermöglichen. Aus mehreren Gründen bedarf ein solches System erhöhter Aufmerksamkeit:um die Architektur aufzubauen, die zu den spezifischen Anforderungen des Unternehmens passt, und nicht die, die die Cloud-Plattformen „vorschreiben“,

- um die Lücken im Hinblick auf das Datenmanagement zu schließen, die der Cloud-Plattform-Anbieter allein nicht füllen kann, wie zum Beispiel Datenintegration, Metadatenmanagement, Data Governance und Datenqualität,

- um zu vermeiden, dass ein weiteres Silo in der Infrastruktur der Cloud-Plattform entsteht

Im Folgenden gehen wir näher auf die Bedeutung eines gesunden Cloud-Datenökosystems ein und erläutern, welche Vorteile es den Unternehmen bringen kann.

Welche Cloud-Architekturen gibt es?

Cloud- und On-Premises-Umgebungen haben ihre eigenen Stärken und Schwächen. Private Clouds und On-Premises-Umgebungen bieten Unternehmen eine größere Kontrolle über ihre Computing-Ressourcen sowie eine höhere Sicherheit. Das Unternehmen verwaltet die gesamte Infrastruktur und kann sie an seine spezifischen Anforderungen anpassen. Eine komplett proprietäre IT-Umgebung ist jedoch kostspielig im Betrieb und in der Wartung, insbesondere wenn ein Unternehmen wächst und mehr Serverkapazität benötigt wird.

Public Clouds hingegen bieten Skalierbarkeit und sind einfacher zu verwalten, da sich der Cloud-Anbieter um die Wartung der Infrastruktur kümmert. Die Architektur einer Hybrid-Cloud bietet Unternehmen Flexibilität und Sicherheit und bestenfalls gleichzeitig eine skalierbare und kostengünstige Lösung.

Multi-Cloud-Architekturen können aus verschiedenen Gründen für Unternehmen interessant sein. Mit dem „Best of Breed“ Ansatz kann sich ein Unternehmen so jeweils den besten zur Verfügung stehenden Service zunutze machen. Auch wird mit dem Multi-Cloud-Ansatz die Abhängigkeit von einzelnen Anbietern vermieden. Des Weiteren können regulatorische Gründe (zum Beispiel Datenschutz) für die Wahl einer Multi-Cloud ausschlaggebend sein.

Markt & Trends für Cloud

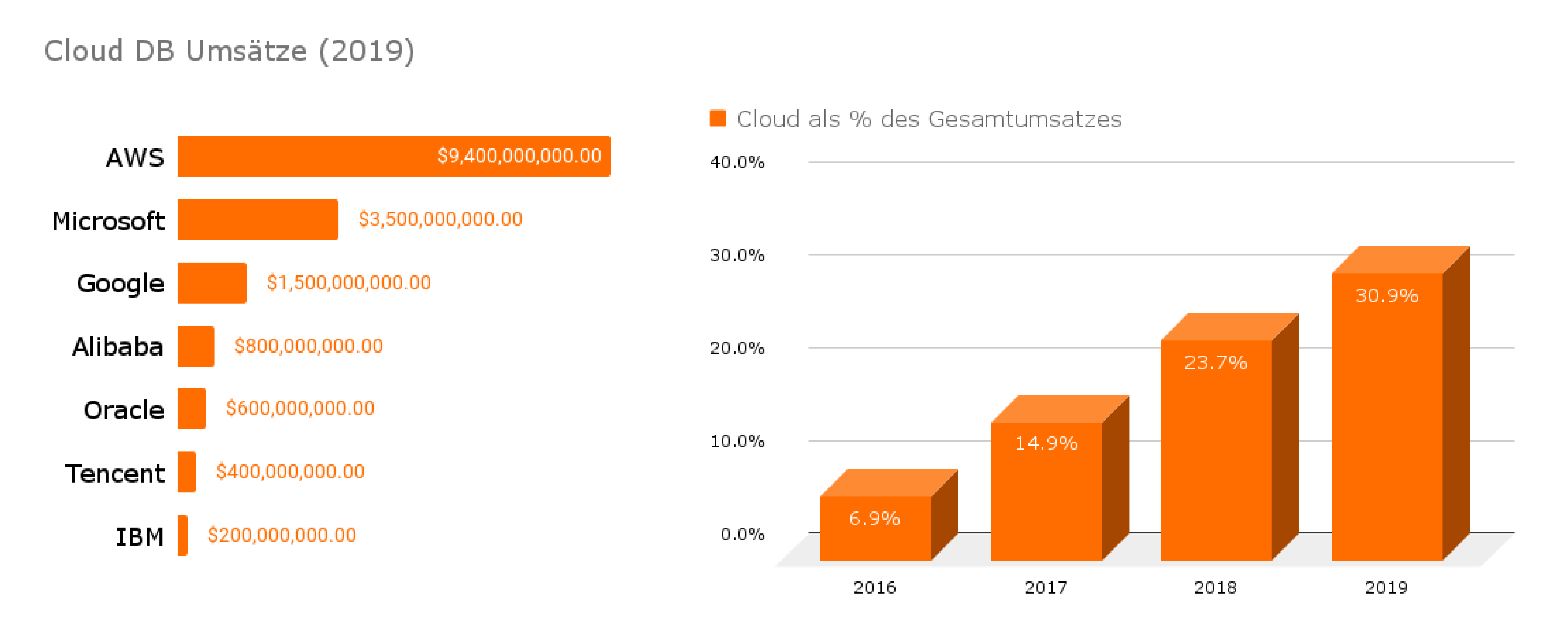

Abb. 1: Das Umsatzwachstumspotenzial der Datenbankmanagement-Systeme liegt in der Cloud (Quelle: Eigene Darstellung nach Gartner [Ron20a])

Der Cloud-Markt wird dominiert von den großen Anbietern Amazon, Google und Microsoft (siehe Abbildung 1). Die wichtigsten Infrastructureas-a-Service-(IaaS-)Plattformen sind Amazon Web Services (AWS), Microsoft Azure und die Google-Cloud-Plattform. Für das Management einer hybriden Cloud wird außerdem ein Wide Area Network (WAN) benötigt, um die öffentliche und die private Cloud zu verbinden.

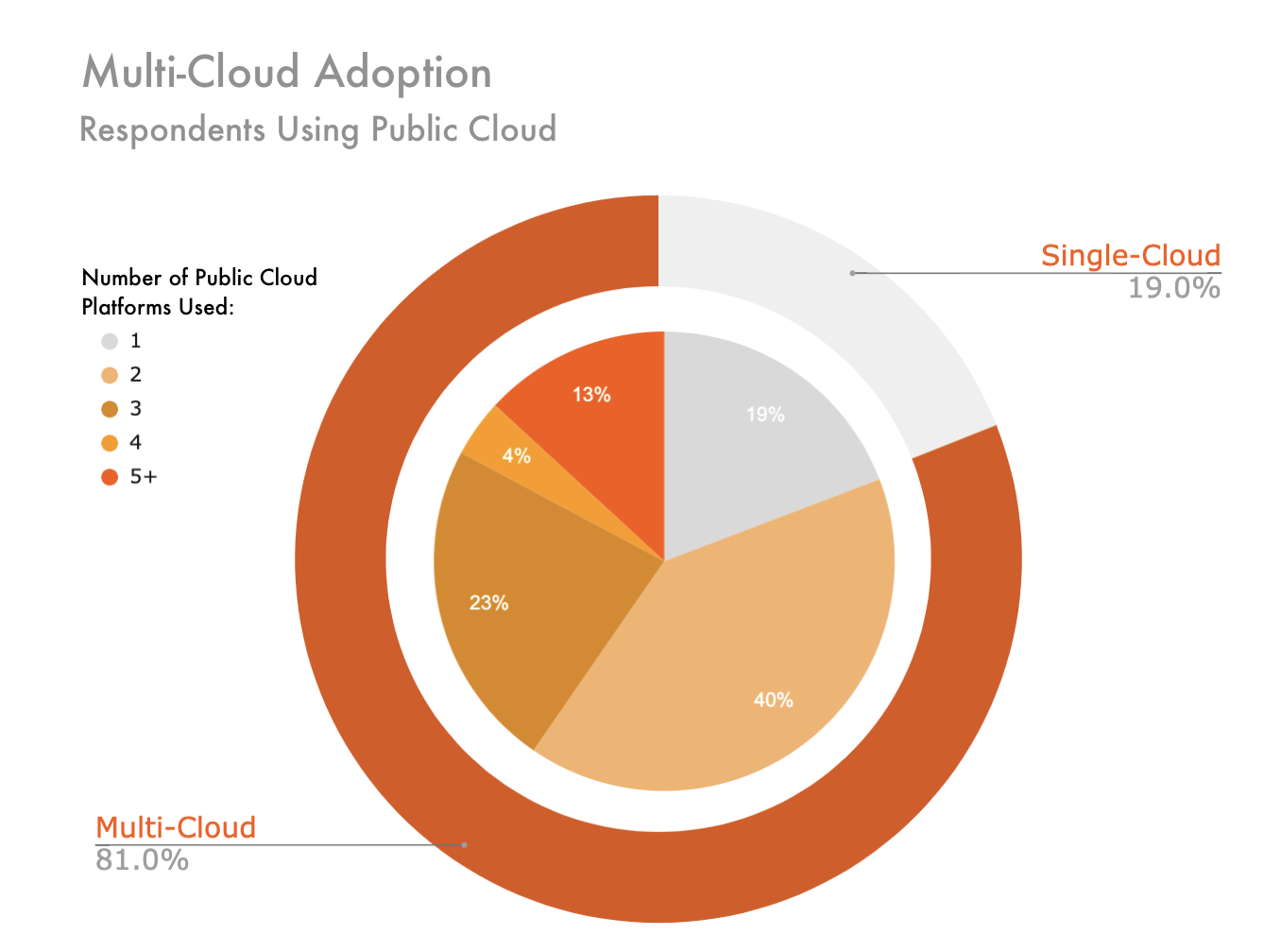

Eine Gartner-Studie [Ron20b] zeigt, dass 81 Prozent der Unternehmen mit zwei oder mehr Public Clouds planen (siehe Abbildung 2). Während 19 Prozent nur eine Public Cloud nutzen wollen, gaben 40 Prozent an, zwei Public Clouds einzusetzen. 41 Prozent planen sogar mit drei und mehr verschiedenen Clouds.

Multi-/Hybrid-Cloud-Architekturen sind also bereits weit verbreitet. Ob diese allerdings auch immer mit durchdachten Strukturen, Prozessen und einem entsprechenden Datenmanagement umgesetzt werden, steht auf einem anderen Blatt.

Abb. 2: Multi-Cloud Verbreitung (Quelle: Eigene Darstellung nach Gartner [Ron20b])

Cloud-Datenökosysteme: Datenmanagement in Multi- und Hybrid-Clouds

Braucht man wirklich mehr als eine Cloud? Multi-Cloud-Architekturen haben tatsächlich entscheidende Vorteile gegenüber Single Clouds:

- Man vermeidet Abhängigkeiten gegenüber einzelnen Anbietern.

- Sicherheitsaspekte oder regulatorische Gründe können den Einsatz der Hybrid- bzw. Multi-Cloud unabdingbar machen.

- Außerdem bleiben Unternehmen, die mehr als eine Cloud nutzen, flexibler, können mit einem „Best of Breed“-Ansatz arbeiten und so jeweils den besten zur Verfügung stehenden Service nutzen.

Natürlich bringt der Einsatz von Multi- und Hybrid-Cloud-Architekturen verschiedene Herausforderungen für das unternehmensinterne Datenmanagement mit sich. Daher ist eine gut durchdachte Datenstrategie im gesamten Cloud-Datenökosystem entscheidend für den Erfolg. Dabei sind unter anderem die Aspekte Datenintegration, Datenqualität, Data Governance, Master Data Management und Metadata-Management für den erfolgreichen Betrieb einer Cloud-Architektur zu berücksichtigen. Darüber hinaus bedarf es einer ausgeklügelten Strategie in Bezug auf Datensicherheit, Nutzerverwaltung und Berechtigungen.

Die großen Cloud-Anbieter stellen hierfür ihre eigenen Lösungen bereit und haben sich so ein eigenes Ökosystem aufgebaut. Diese sind aber meist sehr restriktiv, unter anderem weil sie nur bestimmte Komponenten des Datenmanagements berücksichtigen, die lediglich innerhalb der eigenen Cloud-Plattform funktionieren, und die Anbindung anderer Datenquellen oft kompliziert bis unmöglich ist. So hat man in den meisten Cloud-Plattformen wie Google Cloud Platform keine Möglichkeit, eine neutrale Datenvirtualisierungsschicht als zentralen Datenzugriffspunkt des Unternehmens zu bauen. Daher bietet es sich an, für die wichtigsten Datenmanagementfunktionen in einem „Cloud-Datenökosystem“ Spezial-Tools von Drittanbietern zu nutzen.

Mit alten Konzepten für Datenarchitekturen (zum Beispiel Data Lake, Data Warehouse) kann diese neue Systemlandschaft nicht mehr abgedeckt werden. Man braucht neue Konzepte und Ideen. So wird unter anderem von Gartner das Konzept „Data Fabric“ forciert (siehe unten).

Datenintegration/Datenvirtualisierung

Datenintegration ist der Prozess der Zusammenführung von Daten aus mehreren unterschiedlichen Quellen. Je nach Use-Case eignet sich die eine oder andere Datenintegrationsform besser, so auch bei Multi- und Hybrid-Cloud-Architekturen.

Bei ETL (Extract, Transform, Load) und ELT (Extract, Load, Transform) sind die entscheidenden Schritte das Einlesen, Bereinigen, Zuordnen und Umwandeln der Daten.

Die Datenvirtualisierung (DV) ist eine Technik der Datenintegration, die sich von der klassischen Vorgehensweise ETL und ELT unterscheidet. Mit DV können Unternehmen komplexe und heterogene Datenlandschaften verwalten, Datensilos vereinen (oder ganz vermeiden) und nachhaltige Data Governance realisieren. Durch die Nutzung der Datenvirtualisierung wird die Datenintegration extrem vereinfacht. Daten müssen ihren Speicherort nicht verlassen und Unternehmen erhalten so die Agilität und Flexibilität ihres Datenökosystems: Die Daten sind sicherer und ein Anbieterwechsel wird leichter möglich. Weiterhin können Unternehmen auf diese Weise auch mit sensiblen Daten datenschutzkonform arbeiten. Neue Datenquellen können problemlos angebunden und neue Anforderungen und Ideen schnell getestet werden.

Die Vorteile der Datenvirtualisierung sind unbestritten. Allerdings sollten auch die Herausforderungen nicht unberücksichtigt bleiben. Beispielsweise ist die Datenvirtualisierung keine skalierbare Lösung bei großen Datenmengen oder wenn viele Abfragen parallel getätigt werden müssen. Zudem ist sie stark abhängig von der Geschwindigkeit und Stabilität der Quellsysteme und des Netzwerks, worunter die Performance leidet.

Mit dem Aufkommen der Cloud-Angebote hat sich die monolithische Situation der Datenspeicherung und Datenverarbeitung geändert. Die Daten können jetzt in verschiedenen Komponenten in der Cloud-Architektur gespeichert und verarbeitet werden. Diese Komponenten weisen unterschiedliche Merkmale in Bezug auf Leistung, Kosten und Sicherheit auf. Um eine optimale Kombination dieser Komponenten zu nutzen, reicht eine Datenverbindung über Datenvirtualisierung alleine nicht aus und es sind weitere Datenintegrationsansätze wie Datenreplikation notwendig.

Trends führen zu einem stärker Use-Case-zentrierten Ansatz

2009 stellte Mark Beyer von Gartner das Konzept des Logical Data Warehouse (LDW) wie folgt vor: „Das Logical Data Warehouse ist eine Datenmanagementarchitektur für Analysen, die die Stärken traditioneller Repository Warehouses mit einer alternativen Datenmanagement- und Zugriffsstrategie kombiniert.“

Dieses Konzept wurde vor allem durch die Tatsache getrieben, dass die einzelnen Datenintegrationstechnologien wie Datenreplikation (ETL/ ELT) und Datenvirtualisierung allein nicht alle Anwendungsfälle bedienen konnten. Der hybride Ansatz des LDW erlaubt es auf der einen Seite, Daten zu verschieben, wo es notwendig ist, und auf der anderen Seite, Daten zu kombinieren, ohne sie physisch zu bewegen. So ermöglicht das LDW nicht nur eine vollständig integrierte Datenlandschaft, sondern stärkt auch die Transparenz, Governance und Sicherheit für ein gesetzeskonformes System. Dieser Ansatz ermöglicht es Unternehmen, flexible und nachhaltige Datenstrategien für die immer komplexer werdenden Umgebungen umzusetzen.

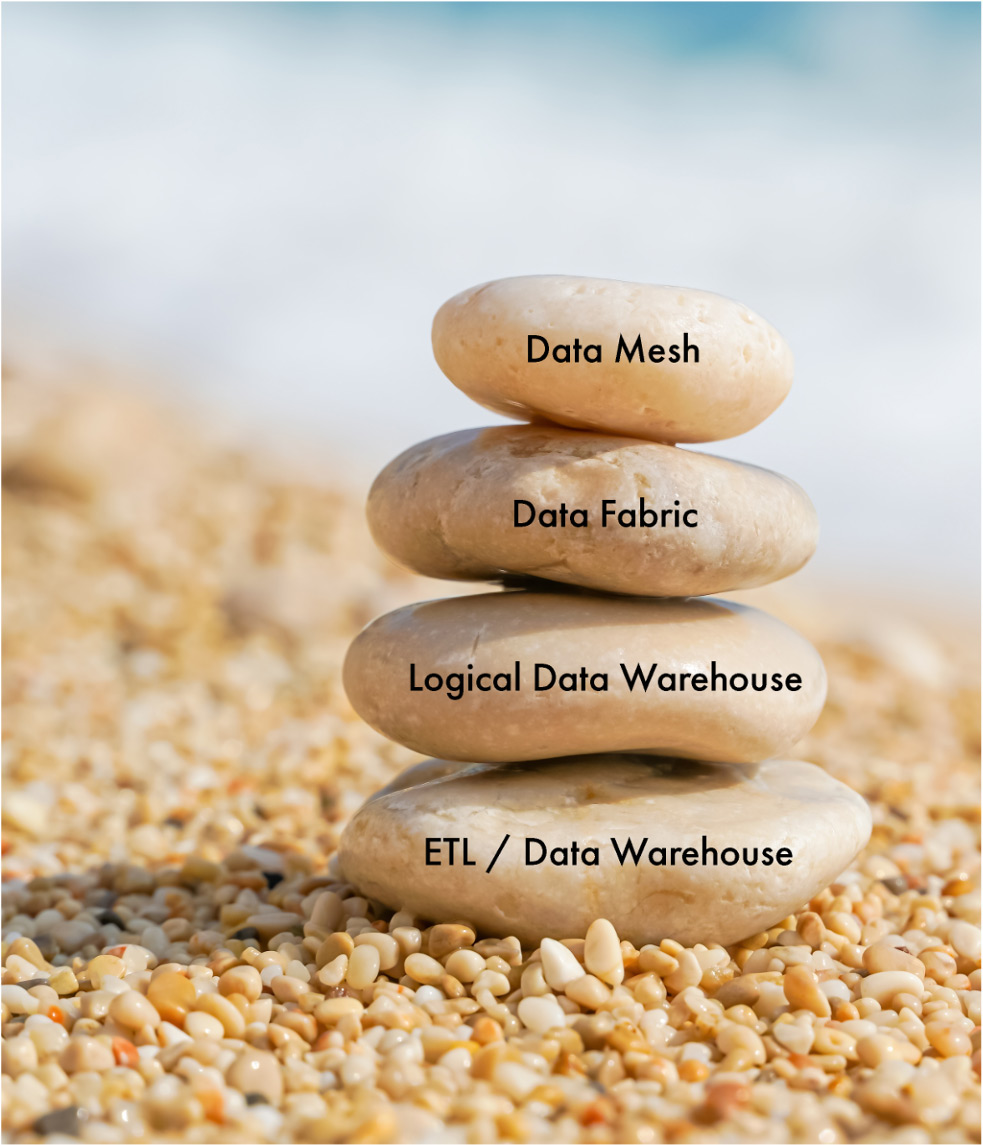

Die aktuellsten Trends wie Data Fabric, Data Mesh, Unified Data and Analytics Platform, Data Platform etc. verfolgen weiterhin den Grundgedanken des Logical Data Warehouse: das Ersetzen der klassischen, monolithischen Ansätze wie Data Warehouse oder Data Lake. Weiterhin weisen all diese Konzepte die Gemeinsamkeit auf, dass mit Hilfe verschiedener Technologien die verteilten Architekturen (auch über Clouds hinweg) integriert werden müssen, um den modernen Anforderungen an die Datenlandschaft gerecht zu werden (siehe bildliche Darstellung der Evolution in Abbildung 3). Sie alle adressieren die folgenden wichtigen Markttrends:

- Die Datenlandschaft wird immer komplexer.

- Agilität wird immer wichtiger.

- Die Anwendungsfälle werden immer vielfältiger.

Abb. 3: Evolution der Datenintegrations-/-managementkonzepte

Data Fabric und Data Mesh

Konzepte wie Data Fabric und Data Mesh können eine entscheidende Rolle bei der Umsetzung von Hybrid- und Multi-Cloud-Architekturen spielen. „Data Fabric beschreibt ein Konzept für das Gesamtmanagement der Datenlandschaft eines Unternehmens mit Schlüsselkomponenten wie Datenintegration, Datenaufbereitung, Metadatenmanagement, Data Governance und Datenorchestrierung.“ [Pow21] „Das Data Mesh [...] basiert auf vier Grundsätzen: bereichsorientiertes dezentrales Dateneigentum und -architektur, Daten als Produkt, Dateninfrastruktur zur Selbstbedienung als Plattform und föderale Computerverwaltung. Jedes Prinzip führt zu einer neuen logischen Sicht auf die technische Architektur und die Organisationsstruktur.“ [Deh20] Die Kombination verschiedener Datenintegrationsansätze gepaart mit Metadatenmanagement und Automation ermöglicht eine schnelle Bereitstellung der Anwendungsfälle aus den Fachbereichen wie Customer 360, Data Science, Betrugserkennung, Internet-of-Things-(IoT-) Analysen, Risikoanalysen und Erkenntnisse im Gesundheitswesen.

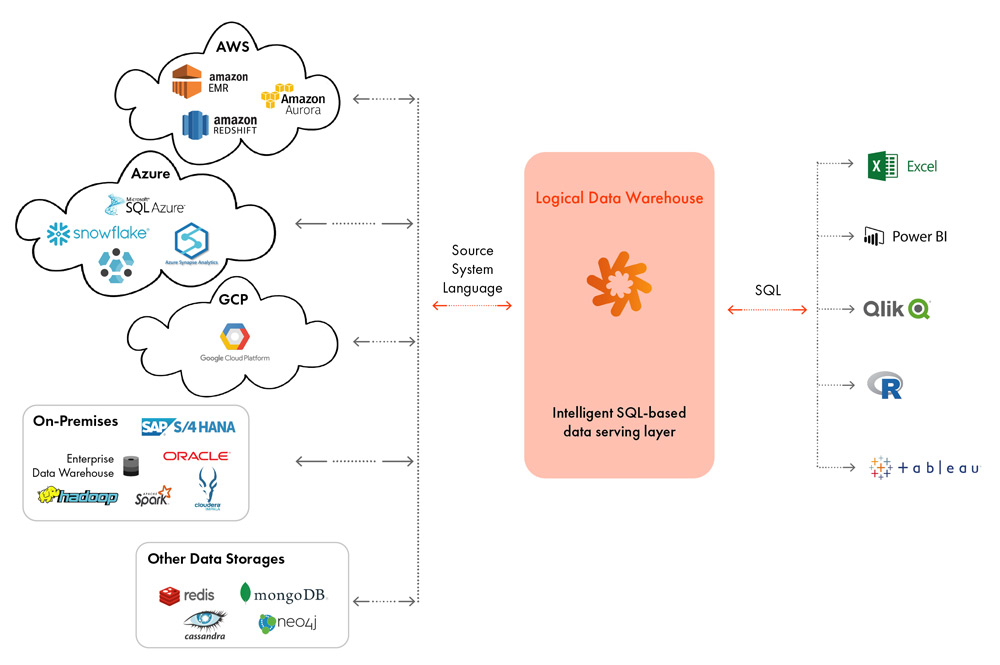

Die Data-Virtuality-Plattform (siehe Abbildung 4) adressiert bereits viele Aspekte eines Data Fabric oder Data Mesh. Durch die Kombination von Datenvirtualisierung und Datenreplikation (ETL/ELT) gepaart mit verschiedenen Datenmanagement-Features wie Metadatenmanagement und AI-basierten Optimizern deckt sie konzeptionell 60–70 Prozent des Data Fabric ab. Es gibt verschiedene Komponenten auf dem Markt, die helfen, die Anforderungen der restlichen 30–40 Prozent eines Data Fabric zu erfüllen. Aber sie zusammenzubringen und für die Gesamtabdeckung der Konzepte zu orchestrieren, ist immer noch eine Vision im Entstehen.

Auch die Anforderungen einer Datenplattform innerhalb eines Data Mesh werden durch die Data-Virtuality-Plattform erfüllt. Diese Plattform ermöglicht die schnelle Entwicklung von Data Products, wodurch die Daten kommerziellen Mehrwert erlangen. „Ein Data Product ist ein Produkt, welches vornehmlich Daten nutzt, um einen Wertbeitrag zur Zielerreichung eines Unternehmens zu leisten. Die Nutzung von Data Products kann über APIs, Services, Berichte und Dashboards erfolgen.“ [Sch20]

Abb. 4: Wie Data Virtuality das Cloud-Datenökosystem unterstützt

Use-Case: Cloud für Finanzinstitute

Finanzinstitute setzen meist auf Hybrid-Cloud-Architekturen. Eine wachsende Liste von globalen Finanzdienstleistern, darunter Bank of America, BNP Paribas, Santander und Royal Bank of Canada, haben sich bereits für hybride Cloud-Modelle entschieden. Die Hybrid Cloud ermöglicht es Instituten, je nach Bedarf auf- und abwärts zu skalieren, und bietet sowohl sofortige als auch langfristige Flexibilität, um sich an die sich ständig ändernden Bedingungen anpassen zu können.

Zudem bietet eine ausgefeilte Hybrid-Cloud-Strategie eine Reihe von weiteren Vorteilen für Finanzinstitute:

- Die Hybrid-Cloud hilft Banken, ihren Datenbedarf in Echtzeit zu skalieren, was die teure Vorhaltung ungenutzter digitaler Kapazitäten vermeidet.

- Die Hybrid-Cloud ermöglicht es Banken, digitale Ressourcen schnell dorthin zu verlagern, wo sie gebraucht werden, und so auf veränderte Kundenanforderungen zu reagieren.

- Die Hybrid-Cloud beschleunigt Innovationen, da sie nicht auf einen bestimmten geografischen Standort oder sogar eine bestimmte Organisation beschränkt ist.

- Sicherheitsbedrohungen ändern sich ständig, und die Hybrid-Cloud gibt Banken Zugang zu Tools wie KI, die für die Identifizierung und Bekämpfung von Cyber-Bedrohungen entscheidend sein werden.

Finanzinstitute sind seit jeher Early Adopter von Datenmanagement-Technologien. Bei Cloud-Optionen ist es nicht anders. Viele haben die Potenziale erkannt, und die rechtlichen, regulatorischen und Compliance-Anforderungen im Finanzsektor zwingen diese Unternehmen geradezu dazu, auf Multibzw. Hybrid-Cloud-Architekturen zu setzen.

Aktuelle Beispiele: Implementierung von Hybrid-/MultiCloud-Strategien bei Finanzinstituten

- Westpac, die älteste Bank Australiens, hat ihre Bankdienstleistungen migriert und einen neuen Cloud-Ansatz gewählt, um ihren Kundenservice zu verbessern. Das Ergebnis: Die Zeit für die Einrichtung neuer Anwendungen wurde von 19 Tagen auf nur 3–5 Tage verkürzt und die Einrichtungskosten um mehr als 30 Prozent gesenkt. [Lim20]

- Die Royal Bank of Canada hat eine anspruchsvolle Cloud-Lösung eingeführt, wurde dadurch agiler und verkürzte die Markteinführungszeit für neue Produkte und Dienstleistungen, während es gleichzeitig einfacher wurde, neue Technologien zu implementieren. [RBC13]

- Kürzlich hat die Bank of America eine Hybrid-Cloud speziell für die Finanzbranche eingeführt, mit Cloud-Services, die für die speziellen Anforderungen der Branche konzipiert wurden. [IBM20]

- Die Deutsche Bank verkündete im vergangenen Juli ein Bündnis mit Google. [Deu20]

- Die Commerzbank will sowohl mit Microsoft als auch mit Google kooperieren (also im Ansatz eine „Multi-Cloud-Strategie“). [Fli21]

Fazit

Moderne Cloud-Architekturen bieten Unternehmen neue Möglichkeiten, ihre Daten zu verwalten und mit ihnen zu arbeiten. Alte Konzepte des Datenmanagements wie Data Lake oder Data Warehouse können die neuen Realitäten oft nicht abbilden. Deshalb bedarf es innovativer Ansätze des unternehmensweiten Datenmanagements unter Berücksichtigung der Chancen und Risiken des Cloud-Einsatzes.

Für den Gesamterfolg der Cloud Journey im Sinne eines erfolgreichen und nachhaltigen Cloud-Datenökosystems sollte ein Unternehmen bei der Einführung einer Cloud-Architektur folgende Aspekte stets im Blick haben:

- Ist eine Single- oder eine Hybrid-/Multi-Cloud-Architektur besser für Ihr Unternehmen? Für nachhaltiges, agiles und flexibles Datenmanagement ist aus unserer Sicht die Antwort darauf eindeutig.

- Für eine optimale Nutzung von Hybrid-/Multi-Cloud-Architekturen spielen Spezial-Tools von Drittanbietern eine entscheidende Rolle. Die von Cloud-Anbietern angebotenen Möglichkeiten für Datenintegration (-virtualisierung), Metadaten, Data Governance und Datenqualität sind hauptsächlich auf die Daten ausgerichtet, die sich bereits in den Cloud-Datenspeichern des Anbieters befinden. Nur ein Drittanbieter kann die Unternehmen davon befreien, all ihre Daten in eine Single Cloud verschieben zu müssen.

- Wie wichtig ist dem Anwenderunternehmen Unabhängigkeit von einzelnen Anbietern und Flexibilität durch einen „Best of Breed“-Ansatz?

Weitere Informationen

[Deh20] Dehghani, Z.: Data Mesh Principles and Logical Architecture. 3.12.2020, https://martinfowler.com/articles/data-mesh-principles.html, abgerufen am 9.9.2021

[Deu20] Deutsche Bank: Deutsche Bank und Google wollen mit langfristiger und weltweiter strategischer Partnerschaft das Bankgeschäft grundlegend transformieren. 7.7.2020, https://www.db.com/newsroom_news/2020/deutsche-bank-und-google-wollen-mit-langfristiger-und-weltweiter-strategischer-partnerschaft-dasbankgeschaeft-g-de-11628.htm, abgerufen am 9.9.2021

[Fli21] Flinders, K.: Commerzbank picks Google for cloud migration. 31.3.2021, https://www.computerweekly.com/news/252498684/Commerzbank-picks-Google-for-cloud-migration, abgerufen am 9.9.2021

[IBM20] IBM Newsroom: Camire, K.: IBM and Bank of America Advance IBM Cloud for Financial Services, BNP Paribas Joins as Anchor Client in Europe. 22.7.2020, https://newsroom.ibm.com/2020-07-22-IBM-and-Bank-of-America-Advance-IBM-Cloud-for-Financial-Services-BNP-Paribas-Joins-as-Anchor-Client-in-Europe, abgerufen am 9.9.2021

[Lim20] Lima, R. K.: Why Financial Services Providers Are Turning to Hybrid Cloud. 15.1.2020, https://www.ibm.com/blogs/think/2020/01/why-financial-services-providers-are-turning-to-hybrid-cloud/, abgerufen am 9.9.2021

[Pow21] Powell, J. E.: Q&A: Data Fabric Use Cases Emerging for Modernization. 4.6.2021, https://tdwi.org/articles/2021/06/04/arch-all-data-fabric-use-cases-emerging-for-modernization.aspx, abgerufen am 9.9.2021

[RBC13] RBC: RBC announces RBC Secure Cloud: the first cloud-based mobile payments solution in Canada. 18.7.2013, http://www.rbc.com/newsroom/news/2013/20130718-secure-cloud.html, abgerufen am 9.9.2021

[Ron20a] Ronthal, A.: Market Guide for Analytics Query Accelerators, 9.12.2020, https://www.gartner.com/document/4001808?ref=solrImgSearch&refval=300084277, abgerufen am 13.9.2021

[Ron20b] Ronthal, A.: Understanding Cloud Data Management Architectures: Hybrid Cloud, Multicloud and Intercloud, 27.5.2020, https://www.gartner.com/document/3985689?ref=solrResearch&refval=300083439, abgerufen am 13.9.2021

[Sch20] Schwan, P.: Data Product. 22.12.2020, https://www.pschwan.de/digitalisierung/was-ist-das-ein-dataproduct, abgerufen am 9.9.2021