Von allen Sinnesorganen des Menschen ist der Sehsinn für die Wahrnehmung der Umwelt der wichtigste: Er liefert rund 80 Prozent aller Informationen. Weil der Sehsinn so wichtig ist, wird er in vielen technischen Anwendungen nachgebildet. Anstelle des Auges tritt dabei die Kamera und ein Computer übernimmt die Aufgabe des Gehirns. In der klassischen Bildverarbeitung werden sogenannte „Merkmale“ berechnet, die den gezeigten Inhalt des aufgenommenen Bilds möglichst gut charakterisieren. Beliebte Merkmale sind Kanten, Ecken oder andere geometrische Primitiven, welche sich mittels sogenannter Filter extrahieren lassen. Mustererkennungsverfahren aus der Statistik oder der Künstlichen Intelligenz (KI) überführen diese Merkmale dann in Aussagen über den Bildinhalt, etwa in die Aussage „Frau“, wenn das Bild eine weibliche Person zeigt.

Die Leistungsfähigkeit hängt dabei stark vom Geschick bei der Wahl und Zusammenstellung der richtigen Merkmale und Verfahren ab. Hierbei ist viel Erfahrung und auch „Ausprobieren“ erforderlich. Eine teils beschwerliche Arbeit, die dank Deep Learning oder tiefen neuronalen Netzen erleichtert wird. Denn nun werden die Rohdaten direkt verarbeitet und dabei die Merkmale – etwa die richtigen Filter – automatisch bestimmt.

Herausforderungen beim Griff-in-die-Kiste

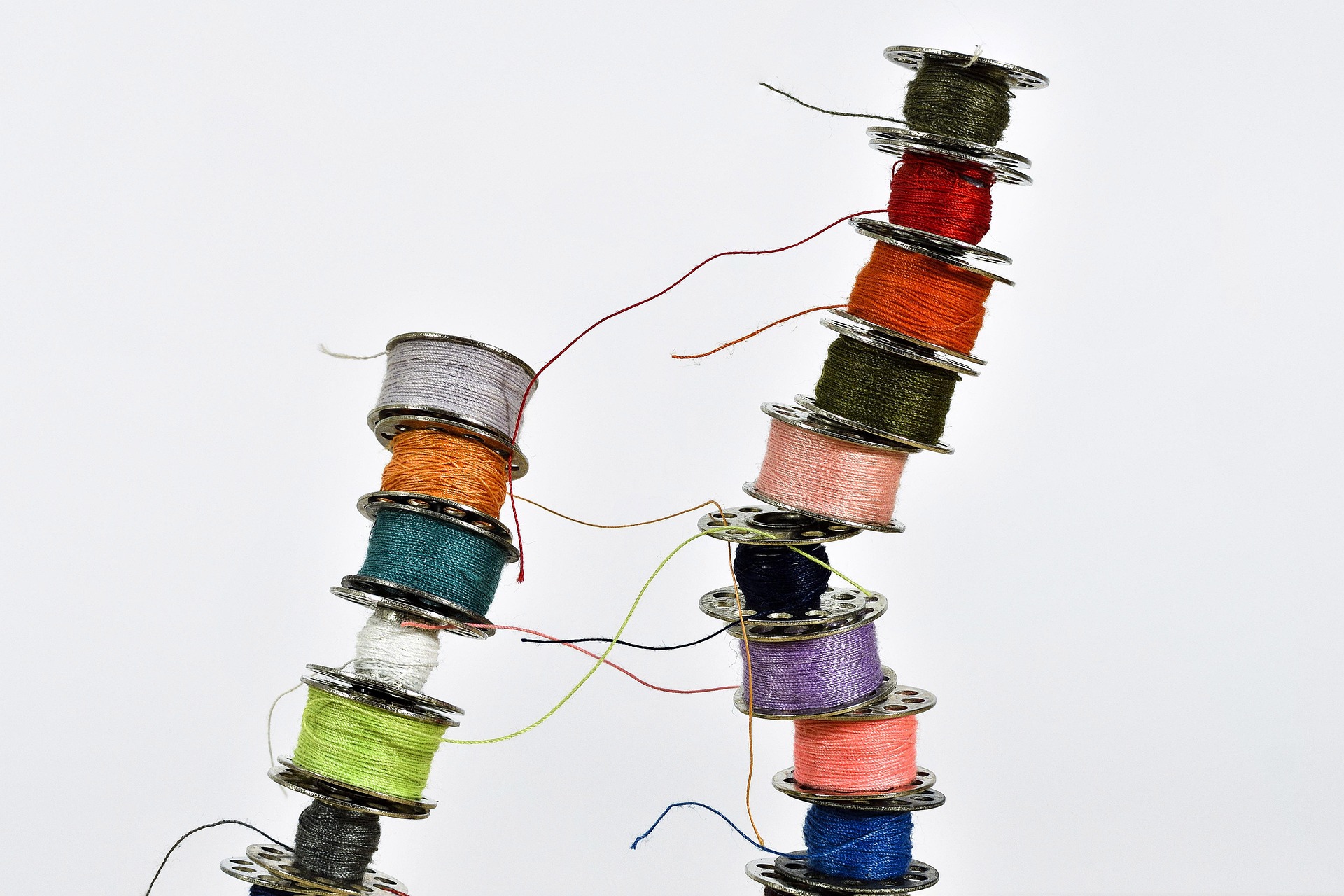

Aktuelle Entwicklungen in diesem Kontext bringen beispielsweise den „Griff-in-die-Kiste“ auf ein neues Niveau. Bei dieser Anwendung geht es darum, dass ein Roboter chaotisch gelagerte Bauteile aus einem Werkstückträger entnimmt und für die Weiterbearbeitung passend ablegt. Die Einrichtung des Systems oder Umrüstung bei neuen Bauteilen ist bislang noch aufwendig, denn neue Objekte werden manuell mithilfe von CAD-Daten eingelernt. Auch gibt es Verbesserungspotenzial im Ablauf der Anwendung: Dazu gehört das Greifen von Objekten, die in den Ecken oder am Kistenboden liegen, sodass die Kiste ganz entleert wird – ein wichtiges Qualitätsmerkmal. Dies ist insbesondere dann schwierig, wenn die Bauteile zum Beispiel glänzende Oberflächen haben oder aufgrund ihres Aussehens schwer vom Kistenboden zu unterscheiden ist (s. Abb. 1).

Abb. 1: Manche Werkstücke wie dünne glänzende Blechteile können dank maschinellem Lernen und einem neu entwickelten Greifer deutlich besser erkannt und gegriffen werden (Quelle: Fraunhofer IPA/Foto: Rainer Bez)

Was dem menschlichen Auge leicht fällt, ist für die Bildverarbeitung beim Griff-in-die-Kiste noch eine Herausforderung. Maschinelle Lernverfahren sorgen hier für signifikante Verbesserungen und können auch bei verrauschten oder unvollständigen Sensordaten zu verlässlichen Greifhypothesen führen sowie Greifstrategien bei Teilen zum Beispiel mit Verhakungsgefahr entwickeln. Voraussetzung hierfür ist, dass ein neuronales Netz mit umfangreichen Datenmengen trainiert wird.

Mehrwert von Simulationen

In der realen Welt ist ein solch datenintensives Training mit zum Beispiel mehreren Hunderttausend Beispielgriffen nicht möglich. Maschinen würden unnötig belastet, der Zeitaufwand wäre hoch und ausreichend bereits gelabelte Daten sind nur selten vorhanden. Die Lösung hierfür ist, maschinelle Lernverfahren mit dem „digitalen Zwilling“ zu kombinieren. Letzterer umfasst ein digitales Abbild der Anwendung sowie leistungsfähige Simulatoren. So können Handlungen bereits virtuell erlernt und optimiert werden (s. Abb. 2). Und dies schneller als in Echtzeit. Das Gelernte lässt sich dann unter Verwendung spezieller Techniken auf die reale Anwendung übertragen.

Abb. 2: In einer Simulationsumgebung werden Algorithmen für die Bildverarbeitung trainiert und das Gelernte dann auf die reale Anwendung übertragen (Quelle: Fraunhofer IPA/Kilian Kleeberger

Die Daten aus einer Simulation sind beispielsweise hinsichtlich Farbe oder Tiefenbild perfekt und ermöglichen ein Training unter Idealbedingungen. Dass es diese Idealbedingungen in der realen Anwendung nicht gibt und mitunter ungenaue, also verrauschte, Sensordaten vorliegen, lässt sich berücksichtigen: So können auch in der Simulation Daten unterschiedlicher Qualität zum Lernen verwendet und künstliches Rauschen aufaddiert sowie Hintergrund, Licht- und Farbnuancen variiert werden, um auf Basis der vielen simulierten Varianten eine Generalisierung in der realen Welt zu erreichen.

Ein Beispiel für eine bereits bestehende Simulation ist die Lernumgebung für den Griff-in-die-Kiste, die im Projekt „DeepGrasping“ entwickelt wurde. Anhand von Tausenden Beispielen mit Befüllungen von Kisten lernte die Software zu verallgemeinern und beliebig gelagerte Objekte zu erkennen. Die Schritte für die Objekterkennung reichten von der Segmentierung der Pixel, also dem Zuordnen von Bildpunkten zu Klassen, über das Erkennen von zusammenhängenden Flächen als Objekt, das Klassifizieren der erkannten Objekte bis hin zur Schätzung der sechsdimensionalen Lage des Objekts.

Einsatzbereiter Datensatz

Während das Training der Algorithmen durch die Simulationsumgebung umsetzbar ist, stellt sich als weitere Frage, woher ML-Experten und -Anwender ausreichend große annotierte Datensätze von Objekten bekommen, um ihren Algorithmus zu perfektionieren. Hier tut sich in der Forschung gerade viel. So hat ein Team um den Wissenschaftler Kilian Kleeberger am Fraunhofer IPA einen Datensatz von rund 200 Gigabyte generiert, mit dem Algorithmen das Lokalisieren von Objekten trainieren können. Hierfür wurden die Datensätze von acht bereits in der Forschung verbreiteten Objekten nachgebaut und erweitert und zudem Datensätze für zwei ganz neue Objekte – eine Ringschraube und eine Getriebewelle – erstellt.

Mit 500 Punktewolken und passenden Tiefenbildern realer Szenarien sowie 206.000 simulierten Szenarien ist der Datensatz sehr groß, zudem vollständig annotiert und einfach erweiterbar. Gerade die Erstellung und Annotation der Realdaten ist aufwendig, denn auf jedem Bild eines Werkstückträgers muss manuell die Lage jedes darin enthaltenen Objekts erfasst werden. In der Simulation dagegen ist diese immer bekannt. Was den IPA-Datensatz nicht zuletzt von bestehenden abhebt, ist seine Industrietauglichkeit. Das wichtigste Kriterium hierfür ist die Draufsicht der Sensoren auf das Griff-indie-Kiste-Szenario. Es gibt lediglich einen weiteren Datensatz in der Forschung, der dies bietet. Er umfasst allerdings nur 2000 simulierte Szenarien und ist daher zu klein, um neuronale Netze zu trainieren. Unter dem Link bin-picking.ai kann der Datensatz heruntergeladen werden. In der zugehörigen Schulung „Cognitive Robotics“, ebenfalls verantwortet von Kilian Kleeberger und seinem Team, vermittelt das Institut, wie sich der Datensatz am sinnvollsten für eine anwendungsspezifische Herausforderung einsetzen lässt.

Blechteile vereinzeln

Eine anspruchsvolle ML-basierte Anwendung für einen Griff-in-die-Kiste bearbeitete das Fraunhofer IPA im Rahmen des EU-Projekts ROBOTT-NET zusammen mit den Partnern Danish Technological Institute, Trumpf, Arnold und dem Start-up für flexible Greiftechnik Formhand. In dem „SoSta“ (Sorter and Stacker) genannten Pilotprojekt ging es darum zu untersuchen, inwieweit eine roboterbasierte Griff-in-die-Kiste-Lösung bei komplexen Blechteilen möglich ist, auch wenn diese in anspruchsvollen Bereitstellungssituationen vorliegen und je nach Folgeprozess getrennt gestapelt werden müssen.

Herausfordernd hier: Die Teile sind glänzend, dünn und besonders die letzten Teile am Kistenboden sind schlecht zu erkennen, weil sie in der 3D-Punktewolke der Kamera mit dem Kistenboden verschmelzen und nur schwer für Bildverarbeitungsalgorithmen wahrnehmbar sind. Deshalb kam erstmals unterstützend Deep Learning zum Einsatz, um die Punktewolke zu segmentieren. Anschaulich gesprochen, schneidet das neuronale Netz die Bereiche der Punktewolke mit Werkstücken aus und übergibt diese an die weitere Bildverarbeitung. In Kombination mit einem flexiblen Sauggreifer von Formhand ergab sich so für den Griff-in-die-Kiste eine entscheidende Verbesserung bei der Vereinzelung von Blechteilen.

KI für die Qualitätssicherung

Auch in der Qualitätssicherung entstehen durch KI neue Möglichkeiten. Aktuell ist die Qualitätssicherung in der Regel ein separater Schritt in der Fertigung. Dieser wird entweder durch eine Endkontrolle, eine Kontrolle nach einem bestimmten Prozessschritt oder eine Mischung von beidem umgesetzt. Bei manuellen Prozessschritten, in denen der Mitarbeiter die Haupttätigkeit durchführt, ist meist eine nachgelagerte Qualitätsprüfung nötig, jedoch auch zeitaufwendig. Diese kann durch einen weiteren Mitarbeiter erfolgen (Vier-Augen-Prinzip) oder sie wird mit einer automatisierten Lösung, oft mit Bildverarbeitung, umgesetzt.

Bildverarbeitungslösungen bedürfen meist fest definierter Beleuchtungsszenarien. KI kann nun dabei helfen, diese Anforderung aufzubrechen und Objekte in unterschiedlichsten Beleuchtungsszenarien zu erkennen. Außerdem können neben den einzelnen Objekten auch Vorgänge über die Zeit einfacher implementiert und auch bei größerer Varianz der Objekte zuverlässig beobachtet werden. Es gibt also nicht mehr nur eine abschließende, statische Qualitätskontrolle, sondern die Schritte des Werkers werden direkt während des Vorgangs beobachtet und ausgewertet.

Unterstützung für den Werker

Dadurch ist es möglich, Assistenzsysteme zu entwickeln, die den Mitarbeiter proaktiv und mit minimaler Zeitverzögerung unterstützen. Die Unterstützung kann durch das Aufbereiten von relevanten Informationen zu Schulungszwecken oder das direkte Hinweisen auf Fehler geschehen. In der manuellen Montage kann zum Beispiel ein Assistenzsystem während des Montagevorgangs überprüfen, ob der Mitarbeiter die Bauteile an die richtige Position platziert und das Ergebnis den Erwartungen entspricht. Sollten sich hier Abweichungen vom Sollprozess ergeben, kann das Assistenzsystem den Mitarbeiter darauf hinweisen und dieser den Fehler schnell und kostengünstig beheben.

Vorteile des „Sorting Guide“

Im Lab Flexible Blechfertigung mit Trumpf Werkzeugmaschinen haben das Fraunhofer IPA und Trumpf den Sorting Guide entwickelt, ein Assistenzsystem für den manuellen Sortierprozess an 2D-Laserschneidmaschinen. Dabei geht es um das prozessoptimierte Absortieren der geschnittenen Blechteile aus dem Restgitter. Die Blechtafeln sind bis zu 2 m auf 4 m groß und wurden mit einem Laser in Blechteile geschnitten. Um eine möglichst optimale Ma-

terialausnutzung zu gewährleisten, werden nicht nur geometrisch unterschiedliche Teile, sondern auch Teile aus mehreren Aufträgen mit unterschiedlichen Folgebearbeitungsschritten auf der gleichen Blechtafel geschnitten (=maximale Materialausnutzung). Der Mitarbeiter muss nach dem Schneidprozess der Maschine die einzelnen Blechteile wieder den korrekten Folgearbeitsplätzen zuordnen. Als Datenbasis dienen hierzu meist die schriftlichen Laufzettel mit Zeichnungen der einzelnen Blechteile. Diesen händischen, oft fehleranfälligen Prozess kann das digitale Assistenzsystem Sorting Guide (s. Abb. 3) optimal unterstützen. Es reduziert effizient Sortierfehler, ermöglicht komplexere Schachtelungen der Aufträge und trägt somit zur optimalen Materialausnutzung bei.

Der Sorting Guide besteht aus einer optischen Sensorik, die den Bereich des Absortierens analysiert, einer mit Künstlicher Intelligenz erweiterten Bildverarbeitung sowie einem Monitor, der dem Mitarbeiter alle relevanten Informationen anzeigt. Um den Mitarbeiter zu unterstützen, erkennt die Bildverarbeitung, welches Teil der Mitarbeiter gerade aus dem Restgitter löst. Am Monitor wird das bekannte Layout der geschnittenen Blechtafel angezeigt, farblich gruppiert nach Teilekategorie. Das aktuell entnommene Teil und die dazugehörige Teilegruppe werden dabei besonders hervorgehoben. So wird unmittelbar klar, welche Teile zusammengehören und idealerweise als nächstes absortiert werden sollten.

Abb. 3: Das Assistenzsystem „Sorting Guide“ von Trumpf und Fraunhofer IPA optimiert die Blechverarbeitung (Quelle: Trumpf Group)

Weniger Fehler und Nacharbeiten

Die Gefahr, dass Teile mit ähnlichen geometrischen Eigenschaften vertauscht oder Teile den falschen Folgearbeitsplätzen zugeführt werden, wird dadurch reduziert. Dies vermeidet teure und zeitaufwendige Nacharbeiten und verhindert, dass Teile am falschen Ort landen.

Ein entscheidender Punkt ist hierbei, wie gut die Bildverarbeitung die Teile erkennt, die der Mitarbeiter entnommen hat. Reflexionen, die Teilevielfalt (oftmals mit Unikaten), eine große Varianz in der Beleuchtungssituation, der große zu beobachtende Bereich und das direkte Eingreifen des Mitarbeiters sind genau die Faktoren, die das Problem so komplex machen. Eine Lösung, die auf klassischer Bildverarbeitung beruht, ist aufgrund der Varianz in mehreren Dimensionen fehleranfällig. Eine Lösung, die auf maschinellen Lernverfahren beruht, ist hingegen rechenintensiv und erfordert eine sehr große Anzahl an Trainingsdaten.

Durch eine intelligente Verknüpfung von klassischer Bildverarbeitung und maschinellen Lernverfahren (ML) kann das Problem robust und performant gelöst werden. Dadurch zeigt sich, dass der sinnvolle Einsatz Künstlicher Intelligenz – als Erweiterung der Methoden zur Bildverarbeitung – eine beeinträchtigungsfreie Qualitätssicherung ermöglicht und diese früher in die Prozesskette integrierbar wird.